Algoritmo, divino tesoro

Por Marcelo Maggio

Hace unos pocos años, allá por los 90, un estudiante de programación leía un manual del lenguaje Turbo Pascal que decía que un algoritmo “es un método para resolver un problema mediante una serie de pasos precisos, definidos y finitos”. Intentaba recordar la definición para aprobar el examen. Aprendió, aprobó y sigue recordando esas palabras del libro de Luis Joyanes Aguilar. El estudiante creció, tuvo hijos, formó una familia. “Papá no entres a Netflix con mi usuario que me desconfigurás el algoritmo y me termina recomendando cualquier porquería”; “tu lista de Spotify sí que te conoce, a mí el algoritmo me tira siempre lo mismo”; “¿viste los últimos videos de Dross en YouTube?, ¿no te salen?, entrená mejor a tu algoritmo”. Solo algunas conversaciones que se dan en la familia, que incorpora no solo nuevos dispositivos y plataformas, sino también un nuevo lenguaje.

Pero, ¿cómo llega el término algoritmo a la vida cotidiana, a la prensa, al trabajo? ¿Por qué alguien que no leyó el libro de Joyanes Aguilar usa algoritmo como término habitual?

El docente de la UNNOBA e investigador en aprendizaje automático, Juan Pablo Tessore, explica que si bien el concepto tradicional de algoritmo no ha cambiado, sí hay que entender que se trata de “dos tipos de algorimos distintos”. “Antes el programador escribía un conjunto finito de instrucciones para resolver un problema, y punto. En cambio los algoritmos que usan Google o Netflix se basan en inteligencia artificial, y son algoritmos a los cuales el programador no les dice explícitamente 'qué hacer' sino que se les especifica un conjunto de parámetros que el algoritmo debe tener en cuenta para luego, y a partir del análisis de un conjunto muy grande de datos, hacer inferencias”.

"Hoy ya queda claro que los datos son 'el nuevo oro' del siglo XXI: todos guardan datos de todo tipo y creen que en algún momento se usarán. No se piensa mucho si esas recopilaciones son o no legales"

Leonardo Esnaola, también docente de la UNNOBA e investigador del área Aprendizaje de Máquina, agrega que “los algoritmos inteligentes surgen en los años 60, pero en ese momento no había la suficiente cantidad de datos ni tampoco un hardware (computadoras) que pudiera hacer operaciones tan demandantes de cálculo como las actuales”. Claro que el abaratamiento de los costos en la informática y, sobre todo, la enorme y gigantesca base de datos que aportó internet derribaron esas dos barreras del pasado reciente. “Antes eran muy pocas las empresas que guardaban datos porque la tarea tenía un costo muy alto e incluso no se sabía qué valor podrían tener esos datos”. Hoy ya queda claro que los datos son “el nuevo oro” del siglo XXI: todos guardan datos (o al menos eso se supone) de todo tipo y creen que en algún momento se usarán. No se piensa mucho si esas recopilaciones son o no “legales”, pero se guardan.

La gran diferencia que marcan los docentes es la irrupción de la inteligencia artificial. Destacan que existe un paradigma tradicional en la programación en el cual se escribe cómo hacer algo, que la computadora luego ejecuta. Pero a partir de la llegada de los nuevos tipos de algoritmos, la computadora puede “aprender” a determinar mediante ejemplos. “Es como una metaprogramación en la que se le dice al algoritmo cómo tiene que aprender para hacer una determinada tarea”. Es por eso que también se usa la expresión “aprendizaje automático”.

Mientras nos conectamos utilizamos plataformas y servicios de todo tipo. ¿Donde están esos datos? "Data center": hoy la nube es sinónimo de datos. Estos lugares almacenan las enormes cantidades de información generada.

Una batalla desde el lenguaje

Otro término que se ha extendido desde el terreno informático es el de inteligencia artificial. Una palabra humana, quizás demasiado humana, como inteligencia comienza a estar asociada a lo maquínico y quizás por eso genera temor, como si se tratara de un verdadero Frankenstein del siglo XXI. Entonces, ¿por qué usar el término inteligencia? ¿No podría usarse otro, como “super herramientas cognitivas”, o similares, que marquen una divisoria entre humano y máquina?

"Las computadoras necesitan una mayor cantidad de ejemplos, por eso la necesidad de reunir gran cantidad de datos".

Para Esnaola es correcto el uso del término inteligencia porque “lo que hace el programa es asimilable al aprendizaje humano, es decir que la computadora sigue un algoritmo de aprendizaje, un cómo, que se basa en ejemplos, y lo hace de modo similar a los humanos”. Y destaca: “Si yo te muestro cómo resolver una tarea con un par de ejemplos, vos aprendés. El problema con las computadoras es que necesitan una mayor cantidad de ejemplos, por eso la necesidad de reunir gran cantidad de datos. La inteligencia está puesta ahí, en el aprendizaje, que pueda hacer cosas que vos, en un inicio y como sucedía con los algoritmos tradicionales, nunca le indicaste”.

Esta utilización del término “inteligencia” había llevado a los pioneros de la computación a un proyecto sin salida, al menos por ahora: lograr una inteligencia artificial completa, incluso con una conciencia. “Ese tipo de inteligencia no se ha logrado, y está muy pero muy lejos de lograrse, aunque lo que sí se ha logrado son estos algoritmos que permiten automatizar un conjunto de tareas que antes tenían que ser realizadas manualmente por una persona”, agrega Tessore. Por eso es que hoy la inteligencia artificial agrupa al gran conjunto de algoritmos que implican un aprendizaje de tipo automático.

De la inteligencia a la realidad artificial

“Hay obras de arte creadas por computadoras”, afirma Esnaola, no sin generar un escalofrío. De alguna manera la “inteligencia” maquínica traspasa los límites de lo matemático y se introduce -o intenta hacerlo- en el terreno de lo sensible y lo creativo, hiriendo el ego humano otra vez. “Hay programas, algoritmos, que pueden crear obras que no existían previamente, como en la pintura. Otros pueden leer música, fragmentos, y crear a partir de ahí. Incluso se han hecho experimentos con obras de William Shakespeare como patrón de aprendizaje”, agrega el docente Tessore.

¿Se puede identificar si es creación o simple mezcla probabilística de variables encontradas? Seguros de la potencia algorítmica nuestros docentes afirman: “Una cosa es que se basó en cómo trabaja o compone un autor para hacer algo parecido, y otra es basarse en la forma de crear de muchos autores". Es decir que ellos apuntan a una verdadera potencia creadora de la máquina. Algo digno de ser discutido pero que ya comenzó.

De hecho ese comienzo lo marca uno de los proyectos más emblemáticos en relación a la creatividad de la inteligencia artificial, el denominado Generative Adversarial Network. Según explican en su web “son un colectivo de amigos, artistas e investigadores impulsados por un conjunto de preguntas y sensibilidades comunes alrededor de la llegada de la inteligencia artificial y el aprendizaje de las máquinas”. Vinculan la inteligencia artificial con el arte y tienen el logro de haber creado la primera pintura hecha por inteligencia artificial vendida en una subasta de la emblemática casa Christie's por la módica suma de 432 mil dólares.

Cómo pensar el algoritmo

Desde el sentido común podría pensarse que para utilizar o generar algoritmos inteligentes se necesitan robots o supercomputadoras. Los docentes de la UNNOBA destacan que “todo depende de la complejidad de la tarea que se quiera realizar”. Lo más importante para ellos es “definir sobre qué datos se va a trabajar y a partir de ahí establecer la tarea”. Clasificaciones, características relevantes y qué se descarta, en qué va a trabajar el algoritmo. “Teniendo los datos y las características relevantes, le damos al algoritmo un conjunto de parámetros a través de los cuales realizar el aprendizaje: ahí comienza el entrenamiento”. Y, como en la escuela, se le hacen las consultas para saber qué tan bien aprendió el señor algoritmo.

Esnaola y Tessore se encuentran embarcados en un proyecto de investigación que forma parte de su Doctorado en Informática. Se trata de reconocer emociones en fragmentos de texto publicados en las redes sociales, para automatizar tareas de análisis que a una persona le pueden llevar miles de horas de lectura. Sobre todo las redes sociales son el gran campo de datos sobre el que se despliegan este tipo de proyectos ya que los datos florecen y son los propios usuarios quienes voluntariamente todos los días brindan sus opiniones y difunden su vida.

Vida privada y huella digital

Sobre el territorio de los datos se despliega también el gran conflicto. Ese nuevo oro intangible de bits tiene una situación legal difusa. Dice Esnaola: “En Argentina tenemos leyes de protección de datos personales, pero como esta tecnología es internacional las barreras de la legislación son grises, ¿dónde aplico la ley, donde residen los datos, donde se obtienen los datos, donde se presta el servicio? Estamos hablando de derecho internacional”.

A partir de los escándalos que cada tanto rodean a las filtraciones de datos cabe preguntarse ¿qué derechos tenemos como usuarios sobre esas “huellas” que dejamos al entrar a internet?, y también, ¿para qué propósitos pueden ser utilizadas? Tessore recuerda algo que sigue siendo central, el acuerdo de los términos y condiciones de cada servicio. “En algunos casos estás intercambiando tus datos por un servicio que es gratuito, y uno voluntariamente al aceptar el acuerdo entregás la información. Lo que debería suceder es que los Estados donde las empresas funcionan puedan determinar qué pueden y qué no pueden recopilar desde una empresa y también qué uso se le puede dar a esos datos”.

El bien y el mal definen por penal

La inteligencia artificial de alguna manera se basa en la creación de sesgos, categorías de personas, para la creación de recomendaciones. Sin embargo están quienes advierten en los peligros que trae este tipo de creaciones, la construcción de prejuicios e incluso la discriminación. Esnaola explica algo que por obvio no deja de ser preocupante: “Los algoritmos están aprendiendo lo que nosotros les enseñamos. Si un equipo de personas se basa en prejuicios para entender o hacer clasificaciones, la tecnología termina aplicando eso mismo”. Incluso hay ejemplos alarmantes como el de “Tay, la robot racista y xenófoba de Microsoft”, un proyecto que duró solo 24 horas online ya que el bot (programa informático que efectúa automáticamente tareas repetitivas a través de Internet) comenzó a abusar de las capacidades de conversación para “responder de forma inapropiada” a los usuarios de Twitter.

Tessore agrega que “hay tareas críticas en las que siempre debería estar la intervención de una persona que supervise al algoritmo o de un ente regulador que determine qué puede y qué no hacer un algoritmo. Podemos conectar un algoritmo inteligente que analice textos al celular de una persona y decidir si sus intercambios son inapropiados o no en relación a algo, como bullying o cualquier otro tema”, pero el algoritmo en estos temas puede ser un recomendador y “en ningún caso quien tome una determinación final”.

Existen posibilidades extremas, como la aplicación de inteligencia artificial a armas (tema abordado en la entrevista con Guillermo Simari en este medio). Los riesgos que implican estos desarrollos van en el sentido de lo que los docentes marcan como “decisiones críticas”. “El algoritmo no es bueno o malo por sí mismo, no se ha logrado que un algoritmo tenga conciencia y diga ‘este profesor es malo y le voy a pegar un tiro’. Por lo tanto lo que consideramos es que, en tareas no críticas y dentro de los marcos de las regulaciones legales, se permita a los algoritmos funcionar de manera autónoma. Un ejemplo de ello serían las sugerencias de videos de Youtube”, indica Tessore.

Y Esnaola agrega en este sentido: “Podés programar un Dron para que vaya a una coordenada y tire una bomba, y eso se puede hacer sin un algoritmo inteligente. Eso se hace con programación. Pero otra cosa es decirle al Dron que sobrevuele una zona y que, basado en una serie de datos que quiero que recoja, elija una resolución y la ejecute. Ahí le estás dando la ‘responsabilidad’ al algoritmo, y eso es lo que no tiene que pasar, sobre todo en tareas críticas en las que está implicada la vida humana”.

Más allá de la distopía

--Tanto desde la prensa, como desde la literatura y la crítica social se sopesa el horizonte distópico por sobre los beneficios de la inteligencia artificial. Ustedes son programadores y es su trabajo desarrollar altoritmos inteligentes, ¿qué utopías o beneficios podemos esperar del desarrollo de estas herramientas, y así dejar atrás las visiones macabras y pesimistas del estilo Black Mirror?

Tessore --En primer lugar destacamos que se puede dar un salto importante en la productividad. Por ejemplo, si un algoritmo puede procesar imágenes para causas judiciales, le da mucho más alcance a la Justicia en relación a la cantidad que puede analizar en comparación con un humano. En segundo lugar, si se combina la Inteligencia Artificial con la robótica podremos utilizar la tecnología en ámbitos que son peligrosos, hostiles o imposibles para los humanos, desde sitios radioactivos a los insalubres o bajo tierra. Creo que junto a la robótica nos da una seguridad para la vida humana en no intervenir en esas tareas de riesgo alto.

Esnaola --Creo que las tareas también van a ir surgiendo de forma creativa, de modo que se va a ir ampliando esta tecnología para mejorar tanto condiciones de vida, como de seguridad o en la economía, por ejemplo. Hay muchas áreas en las que se puede intervenir. Sin embargo esos algoritmos van a ser tan buenos como el entrenamiento que se haga de ellos y van a ser tan confiables como el trabajo que tengan por detrás. Y siempre tienen que haber personas y definiciones éticas que intervengan en esos procesos de entrenamiento. Pero también está lo individual, lo que cada uno quiera para su vida: ¿cuánto confiamos en la tecnología, cuánto queremos que haga por nosotros? Ahora en Gmail hay sugerencia de texto mientras se escribe, ¿eso es bueno o malo? ¿Google se está “metiendo” en tus textos? Cada uno, cada persona humana, tendrá que aprender a tomar sus decisiones también.

PERFILES:

Leonardo Esnaola es egresado y docente de la UNNOBA en las asignaturas Gestión de Proyectos y Sistemas Inteligentes en las carreras de Informática. Es también investigador del Instituto de Investigación y Transferencia de Tecnología de la UNNOBA y doctorando en Informática en la Universidad Nacional de La Plata. Se especializa en aprendizaje automático.

Juan Pablo Tessore es egresado de la UNNOBA y docente en la asignatura Lenguajes de Programación y Compiladores en la UNNOBA. Es investigador del Instituto de Investigación y Transferencia de Tecnología de la UNNOBA y becario doctoral de la CIC de la provincia de Buenos Aires y cursa el doctorado en Informática en la Universidad Nacional de La Plata. Se especializa en aprendizaje automático.

Créditos:

Producción y edición de video: AURA UNNOBA

Adaptación de imagen: Laura Caturla

De Junín a las estrellas

Por Marcelo Maggio

La nave espacial iba rumbo a un destino pautado, otro planeta lejano y desconocido, por eso toda la tripulación estaba en hibernación. Sin embargo, debido a un cúmulo de “materia oscura” fueron a parar a otra parte, muy lejos del punto de destino, en el medio de algún lugar del espacio. La escena corresponde a la serie Otra vida (Netflix, 2019) y no es una casualidad que la materia oscura ya sea un tema de la ciencia ficción: es una parte de la Física que está ahí para ser investigada porque arroja muchísimas preguntas y rompe con todo lo previsto hasta ahora, incluso en la ficción.

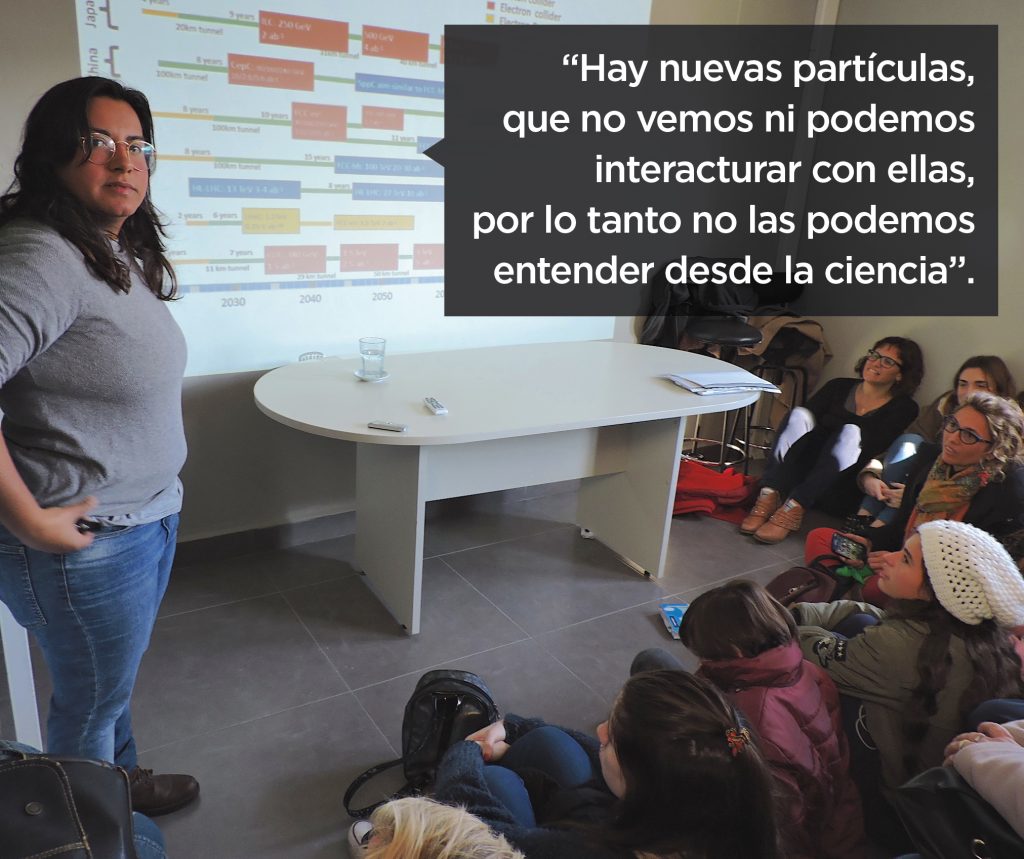

“La materia oscura es el próximo escalón a seguir por parte de la Física y en ella se centran la mayoría de los esfuerzos actuales de la disciplina. Su estudio promete abrir nuevos horizontes sobre la comprensión de la realidad”, plantea Florencia Castillo, quien dictó la charla “El lado oscuro de la materia” en el aula del Centro de Investigaciones Básicas y Aplicadas de la UNNOBA, ante un auditorio intrigado y sorprendido.

Ella asegura que desde muy chica tenía la costumbre de mirar al cielo en la noche y repetirse siempre la misma pregunta: ¿por qué brillan las estrellas? Seguramente en el patio de su casa de Junín, o al volver muy tarde en una jornada invernal del Colegio Parroquial San José. Pero ella, no se quiso quedar con la duda y rumbeó hacia la Universidad Nacional de La Plata, con 17 años, y muchas preguntas, para estudiar Astronomía.

A los 23 años ya estaba recibida, con premios y cartas de recomendación. No tuvo tiempo de volver a Junín a despedirse de su familia, cuenta entre lágrimas, porque la estaban esperando en Valencia. Florencia Castillo había ganado una de las tres becas doctorales que otorgó el Instituto de Física Corpuscular (IFIC, CSIC-Universidad de Valencia) en 2017.

Para entender las estrellas tenía dos caminos: seguir mirando el cielo o hacer todo lo contrario, buscar las respuestas en las partes más pequeñas de la materia: las partículas. “Podés hacer Física de colisionadores, como la que yo hago, y lo más importante que hay ahora en este terreno es el Conseil Européen pour la Recherche Nucléaire -más conocido por sus siglas CERN-, que tiene cuatro detectores y en dos de ellos es que se hace la búsqueda de la materia oscura”. El IFIC de Valencia está asociado al CERN, y por eso su trabajo depende de las líneas de investigación que allí se aprueben y experimenten.

¿Cómo es trabajar en el laboratorio más grande del mundo? ¿Qué se siente caminar por los pasillos que alguna vez caminó Tim Berners Lee o alguna otra estrella mundial de la ciencia? Florencia no lo duda y responde: “Para mí es el trabajo que elegí, y espero poder seguir haciéndolo”.

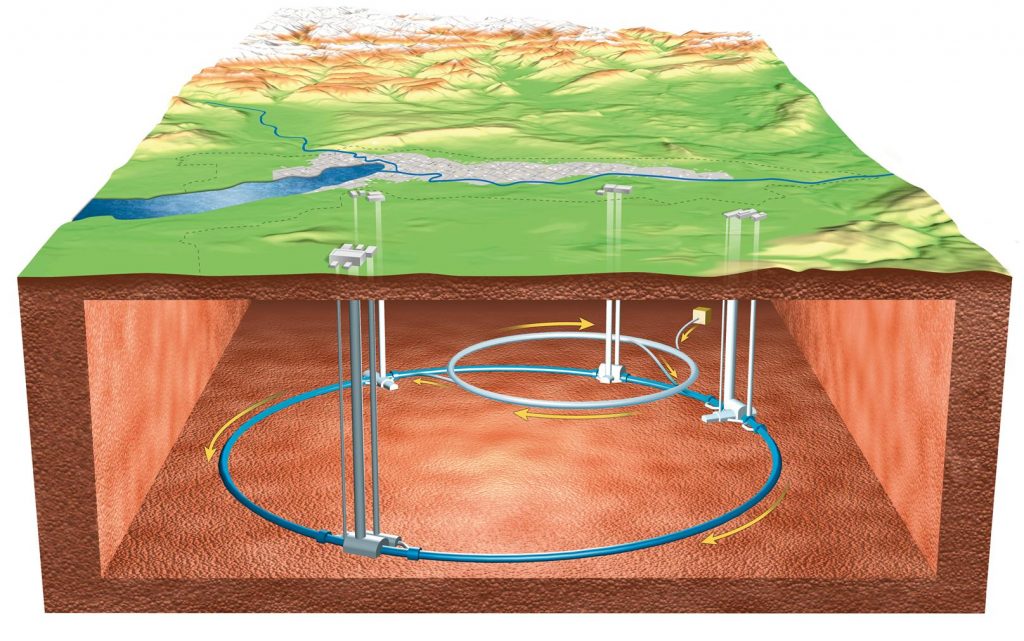

En la actualidad hay una "carrera" por la construcción de laboratorios con detectores de colisiones de partículas. China, Japón y Europa son los que están a la vanguardia, sin embargo por ahora es el CERN quien dispone de la conocida como “máquina de dios”, ese lugar en el que se quieren recrear las condiciones del Big Bang o explosión originaria del universo. Son 38 países y 3 mil personas las involucradas solamente en uno de los detectores, denominado ATLAS, que tiene el objetivo de observar los residuos de una colisión para saber si se ha creado algo nuevo o no. En un inicio, la tarea de Florencia fue, mediante su beca, sumarse a un proyecto y a un grupo para estudiar uno de los temas relacionados con la materia oscura. Ese fue el primer desafío: elegir en qué línea de investigación se iba a adentrar.

Modelos y anomalías

Dentro de la Física está lo que se conoce como el modelo estándar, pero que tiene un problema: solamente puede explicar el 5% de la composición del universo, la materia ordinaria. ¿Qué sucede con el otro 95%? Florencia Castillo explica que “todo empezó con una observación que se hizo a un cúmulo de galaxias, un objeto astrofísico que se puede observar, y con la luz que llegaba se podía calcular la masa y su velocidad gracias a los valores que se conocen por la constante de la gravedad”. Sin embargo “los científicos se encontraron con objetos que tenían mayor velocidad que la que tendrían que tener: ese fue el primer indicio”. Estaban pasando cosas que no respondían a los modelos predictivos establecidos.

Como lo sucedido no se podía identificar ni ver se le asignó el nombre de materia oscura. ¿Cómo es que algo no se puede ver? Simplemente no refleja la luz. Comienzan entonces a construirse modelos teóricos que intentan explicar el fenómeno y a establecerse experimentos que permitan verificar esos modelos. “En el modelo estándar no hay ninguna partícula que haga eso, que se comporte como una materia oscura: reflejan luz, es decir, interaccionan electromagnéticamente. Las teorías para explicar esto son varias. Una de ellas plantea que hay nuevas partículas, que no vemos ni podemos interacturar con ellas, por lo tanto no las podemos entender desde la ciencia”, comenta.

La imposibilidad de interactuar con algo para la ciencia es no poder observarlo ni poder experimentar con ello, “entonces la única manera sería recrear condiciones, como aquellas en las que estas partículas se hayan creado, como el inicio del universo”. Castillo indica que eso es lo que se hace dentro de los colisionadores de partículas.

La más conocida o extendida de estas teorías es la de la supersimetría (o por sus siglas SUSY), la cual propone “una duplicación del modelo estándar”. Otra teoría que se ha hecho popular es la "teoría de las cuerdas", que propone que “las partículas pasan a ser un pequeño filamento, sobre la cual Juan Maldacena, un premiado investigador argentino, desarrolla su trabajo”.

También están quienes postulan la existencia de partículas neutras como los axiones que explicarían el funcionamiento de la materia oscura. Todas estas teorías y modelos intentan predecir y explicar por qué hay más partículas de las que podemos observar. Sin embargo la cuestión se complejiza cuando Castillo afirma que “solo algunas de esas partículas son candidatos a ser materia oscura, otras no”.

Dentro del modelo estándar, la materia puede reflejar ondas electromagnéticas en cualquier frecuencia, desde el infrarrojo hasta el ultravioleta. ¿Pero en el espacio esas ondas se comportan igual que en la Tierra, lugar en el que se puede hacer experimentos? Castillo explica que “la interacción, en este caso, está asociada a la partícula que denominamos fotón”. Y agrega: “Al aplicar el modelo estándar, el fotón está bien entendido y se comporta igual en todos los lugares. Pero si el medio cambia, puede cambiar su velocidad o índice de refracción. La luz la tenemos bien entendida y gracias a eso conocemos mucho del universo: la luz nos dice sobre la temperatura en la que está algo o su composición química”.

Del cielo al ensayo

Nadie llega a un lugar como el CERN, escribe un programa informático, presiona un botón y se pone a colisionar partículas diciendo “este es mi experimento”, poniendo en juego recursos de miles de millones de euros. Suena lógico. “Hay varias etapas -cuenta Castillo-. La primera, cuando entrás en un proyecto como el que requiere utilizar algo como ATLAS, que es de tipo internacional, es tratar de hacer una tarea para mejorar un experimento. Lo que hice en mi primer año fue aplicar ‘simulaciones’ de colisiones de protones para entenderlas un poco mejor, cambiar parámetros para ver cuál predecía mejor los datos que se habían tomado. Luego viene la parte computacional, recrear esa simulación y para eso, por ejemplo, yo desarrollo mi propio software en lenguaje Python y realizar mis propios estudios”.

Si todo va bien en estos ensayos teóricos y simulaciones informáticas, recién ahí se puede pasar a una solicitud de experimento o de lectura en una institución como el CERN, para obtener “los datos que arroja el colsionador”.

“Es necesario tener mejores experimentos -argumenta Castillo- porque es la única forma de avanzar. Esto significa, entre otras cosas, tener que subir la energía para crear partículas más pesadas. También es importante poder colectar más información sobre las colisiones, y para eso es necesario una mejora en la ingeniería del detector, ya no en el colisionador”. Esta propuesta de mejora ya fue aceptada y se la conoce como High Luminosity LHC, y empezará a funcionar en 2026.

Además Florencia Castillo participó en un proyecto de mejoramiento del experimento sobre la detección de la materia oscura, publicado en un paper que explica las condiciones del experimento y las mejoras. “Ahora, además, lo que estoy haciendo es usar otro modelo diferente de producción de materia oscura, porque hay muchos”.

El ensayo a partir de “colisionar partículas” nace de dos teorías: la cuántica y la relatividad. Albert Einstein planteó que la energía se convierte en masa y la masa en energía, que hay una igualdad. El otro ingrediente es la mecánica cuántica, que dice que todo es posible, no en el sentido místico, sino en la Física. Por ejemplo, si hay energía entonces se pueden crear partículas nuevas con determinada masa. “La idea de colisionar partículas es observar en cuáles de los muchos eventos que ensayamos se pueden crear nuevas partículas, nuestro ‘candidato a materia’. Si por modelo estándar sabemos qué tiene que pasar tras cada colisión y lo comparamos con los modelos de materia oscura, podremos saber si ha ocurrido la creación de una partícula desconocida”, refiere Castillo.

El universo está conformado por un 30% de materia y un 70% de energía. Pero Castillo lo explica y desagrega para darle una real dimensión a la importancia de la oscuridad en todo este asunto: “El universo esta formado, aproximadamente, por un 5% materia ordinaria (nosotros, el sol, los planetas), un 25% materia oscura, y el resto, ese 70%, es energía oscura”.

Castillo también detalla la diferencia entre materia y energía oscura, ya que “no son lo mismo”: “La energía oscura es una presión negativa que hace que el universo se expanda aceleradamente, va en contra de la gravedad. Pero la materia oscura, eso que no vemos, hace que las cosas se muevan más rápido de lo que podemos entender. Pero si sumamos ambas contribuciones hablamos del 95% del Universo”.

Across the Universe

---Algo derivado de la ciencia ficción y que plantean algunas series como Star Trek, ¿se puede superar la barrera de la velocidad de la luz?

---No, las teorías que manejamos hoy en día nos dicen que nada va más rápido que la luz. Si quisieras hacer un viaje interestelar, la estrella más cercana al Sol se llama Alfa Centauri, y está a 5 años luz, es decir que tenés que viajar 5 años a esa velocidad para llegar al lugar. Sin embargo, la sociedad tiene que enfrentar varias problemáticas, como la ecológica y, en caso de sobrevivir como especie, agotamiento del Sol, es decir que en algún momento la sociedad se va a tener que plantear la necesidad de viajar a otra estrella, porque el Sol se agotará. Pero actualmente no tenemos idea de cómo hacerlo. Pero entender la materia oscura implica entender un poco más el universo, lo cual podría llevar a realizar esa tecnología.

---¿Y qué pasa con el tiempo? ¿Se lo puede manejar como plantea Einstein a partir de las curvaturas que hay en el espacio?

---Lo que dice la teoría de Einstein es que nosotros estamos en un filamento de espacio-tiempo, si cambiás el filamento te cambia el espacio y el tiempo, ambas. Lo que que plantea es que un objeto masivo, como un agujero negro, curva el espacio y a medida que te acercás cambia el tiempo también. La distorsión del tiempo hace que para una persona en la tierra pasen 10 años y el que está en el agujero negro sólo viva 1 segundo.

---¿La curvatura total se da en el agujero negro?

---La teoría de la relatividad plantea que podemos llegar solamente al horizonte, a lo externo del agujero negro. La otra parte del agujero, la singularidad, que es donde está el agujero del espacio-tiempo, el cual podría llegar a ser un pasaje a otro universo a través de un agujero de gusano. Pero no hay evidencia física de eso, porque para salir de la singularidad tendrías que superar la velocidad de la luz, y por lo que sabemos no es posible superarla.

---En la prensa argentina estuvo presente durante este año la teoría de los terraplanistas a partir de campamentos y una serie de actividades que realizaron. ¿Cómo impacta en tu campo de trabajo la existencia de estos grupos? Es decir, hay un grupo de gente que estaría diciendo que lo que ustedes hacen es meramente conspirativo y falso.

---Creo que darle espacio a ese tipo de pensamientos es también una manera de darle la espalda a la ciencia. La sociedad está hecha de lo que es. Nosotros como científicos decimos lo que estudiamos, cómo lo hacemos y esperamos que la sociedad nos tome en cuenta. Hasta cierto punto es culpa nuestra si se plantean estas dudas, porque tenemos desde la ciencia una responsabilidad social de llevar lo que hacemos. Si nadie se entera de lo que estamos haciendo se da lugar al surgimiento de las especulaciones. Tenemos que llevar la ciencia a la sociedad, porque la ciencia en definitiva es una construcción social y cultural, y si no lo hacemos no se avanza, es más se puede retroceder. Si la sociedad no cree en la ciencia, los científicos en definitiva no tendremos los recursos ni los espacios para trabajar. En España nos exigen que hagamos divulgación, que vayamos a colegios, esa parte social está exigida y así nace la confianza de la gente.

---¿Cómo ves tu futuro?

---¡Oscuro, como la materia! Espero terminar el año que viene en España y ver qué hago. Mi idea es seguir haciendo ciencia, me gustan muchas ramas, no solo la Física de partículas. Vamos a ver con qué puedo seguir y dónde.

- Crédito imagen de portada: "Artistic view of the Higgs Field", publicada por el CERN Document Server

- Diseño: Laura Caturla

- Imágenes gentileza de Florencia Castillo

La Escuela, un encuentro con todos

por Marcelo Maggio

El tercer sorteo se aproxima y la expectativa crece en las familias y en los alumnos que quieren ingresar a ese listado de sesenta que conformará la tercera cohorte de la Escuela Secundaria “Domingo Faustino Sarmiento” de la UNNOBA. El Universitario dialogó con el rector Guillermo Tamarit acerca de los fundamentos, las motivaciones y los objetivos que se buscan con esta unidad académica. ¿Por qué y cómo la Universidad decide intervenir con este énfasis en el nivel medio?

La creación de la Escuela Secundaria forma parte de las decisiones tomadas durante la gestión de Guillermo Tamarit al frente de la Universidad. La presencia del rector tanto en reuniones con docentes como en la comunicación con las familias de los alumnos no es algo casual. “El director de la Escuela es el rector -aclara Tamarit-, y esto es así porque creemos que es una política de primer orden: la Universidad debe involucrarse en la enseñanza media a partir de desarrollar una actividad transferible al resto de la comunidad”. Es decir, que para el rector de la UNNOBA, la importancia de la Escuela va más allá de lo que pueda suceder en el lugar y con sus alumnos. Tiene que tener un "valor agregado" para la comunidad y debe dar un testimonio: “Pretendemos que la sociedad pueda tomar aquello que le resulte valioso de nuestra experiencia”. Un desafío doble.

-¿Cómo definiría el momento institucional en que se decide la apertura de la Escuela Secundaria?

-En primer lugar, la Universidad necesitaba un período de maduración de sus actividades específicas. No podíamos pensar en tener enseñanza media sin consolidar la enseñanza universitaria. Teníamos, además, que salir de esa impugnación que hubo durante mucho tiempo hacia la universidad en general, respecto de que se aislaba del sistema educativo y que asignaba muchas de sus deficiencias a las trayectorias anteriores y, por lo tanto, se desentendía del proceso. Nosotros siempre hemos planteado que el proceso educativo es único, que tenemos que trabajar articuladamente en todos los niveles y, en la primera oportunidad que tuvimos, pasamos a los hechos: nos hicimos responsables de un testimonio mediante una acción concreta. En un momento de crisis del sistema medio en particular, con números muy malos, por ejemplo, la mitad de los estudiantes del secundario no se reciben a la edad que se tienen que recibir, incluso en ese momento, creímos que la Universidad podía tomar el desafío.

"...sin el docente no hay tecnología que pueda resolver ninguna ecuación pedagógica"

-Es decir que no tenía que ver con una cuestión de “competencia” con otros actores escolares sino de complementar el trabajo con el resto del sistema educativo.

-Exactamente. Simplemente se trataba, desde el respaldo que tenemos como Universidad, de tener una institución en la que algunos elementos del modelo puedan ser trasladables al resto del sistema medio, particularmente de la región. Para dar un ejemplo: en el ingreso a nuestra Escuela Secundaria se le garantiza una vacante a cada escuela primaria del distrito de Junín. Eso genera, efectivamente, que haya alumnos de todas las trayectorias educativas, de todas las clases sociales, con una variedad de experiencias. Y este es el primer dato que el resto del sistema educativo puede observar. Muchos nos decían, “por qué no hacen un examen de ingreso para que entren los mejores y tener un colegio de élite”. No, porque eso finalmente segmenta a un sector de la sociedad. No solo es elitista en términos educativos y de conocimientos, sino que tiene un sesgo social brutal: colegios de clase media o media alta con un sentido aspiracional en lo social y en lo económico. No tiene nada que ver con lo que nosotros pensamos cuando proyectamos nuestro colegio.

-¿Cómo se pensó, entonces, ese modelo no elitista en términos de propuesta pedagógica?

-En nuestro colegio tienen que estar todos los chicos, de todos los sectores y el paso por la educación los tiene que igualar. Creo que es allí es donde nos encontramos con el resto de los colegios, porque tenemos los mismos problemas, los mismos alumnos. Nosotros podemos tener más herramientas institucionales por ser una universidad, podemos resolver cuestiones, trasladar esa experiencia, capacitar docentes y, por supuesto, apropiarnos de la experiencia de los otros colegios. Desde el inicio de la Escuela estaba la idea de que el resto de la comunidad educativa nos vea como una herramienta propia, y eso es algo que hay que cuidar todo el tiempo. Por eso estamos en un proceso en el que hay que dar una discusión interna muy fuerte, porque no podemos permitirnos trabajar para una élite que se genere por una dinámica propia en la que, aunque los alumnos lleguen de distintos lugares sociales, después se queden solo los mejores. Sin embargo, tampoco podemos repetir las prácticas que han fracasado en otras instituciones. Entonces hay una tensión con estas cuestiones, incluso con la Escuela ya en funcionamiento. Esto hay que discutirlo fuertemente y nunca perder de vista cuál es el objetivo institucional.

"...hemos recuperado una tradición de nuestro país. La educación argentina, durante la mayor parte de su tiempo, tuvo esa característica: en la escuela nos encontrábamos todos, con todas las experiencias..."

-Ese debate constante, que uno ve que también se mueve con la dinámica de los que ingresan y crecen dentro de la escuela, ¿incluye a todos los actores de la misma forma?

-Sí, a todos, pero la principal carga está en los docentes, una vez más, como en todas las instituciones educativas. No se tienen que “enamorar” de los que sobresalen y tampoco bajar los brazos ante la dificultad.

-¿Cómo evalúa usted la convivencia de los distintos sectores sociales y económicos que componen el estudiantado de la Escuela?

-Yo lo vivo como que hemos recuperado una tradición de nuestro país. A mí me tocó ir al Jardín de Infantes de la Universidad Nacional de La Plata, a su Escuela Primaria y también Secundaria, y en todos estos niveles pasaba así, estaba el hijo del portero, del médico, de un docente universitario. La educación argentina, durante la mayor parte de su tiempo, tuvo esa característica: en la escuela nos encontrábamos todos, con todas las experiencias, y todos lo recordamos como una experiencia valiosa. Éramos iguales en la escuela, y lo estamos recuperando, para que no pase que los pobres tengan que ir a escuelas de pobres y los ricos a escuelas de ricos. Acá todo el mundo va a la escuela. Y en la escuela cada uno vale por lo que hace en la escuela, lleva sus experiencias y las comparte.

-La Escuela Secundaria de la UNNOBA tiene un edificio nuevo, laboratorios, y recursos como comedor o computadoras para cada alumno. A su vez hay un fuerte desarrollo de proyectos pedagógicos y contenido. Pero en el sistema educativo, en general, se suelen contraponer el dinero frente a la pedagogía. ¿Cuál es su posición respecto a esa tensión?

-Sin dudas ha habido una fuerte impronta por lo disruptivo de la tecnología. En un momento todas las políticas del Estado en materia de educación se resumían a entregar una computadora a cada alumno, tuviera o no una conexión, tuviera o no docentes preparados. Pero finalmente la tecnología es una herramienta más. Un proceso pedagógico está dado por ese instrumento o por muchos otros, por eso hay que asumir lo instrumental con un sentido crítico. ¿Cuál es nuestro objetivo? Tener la mayor cantidad de gente con la mejor educación, en todos los niveles. En el nivel secundario queremos dar un testimonio de que, efectivamente, las capacidades de los estudiantes puedan tener un piso equivalente, y para eso son centrales las actividades de los docentes. Entonces hay que invertir mucho más en formación docente que en tecnología, porque sin el docente no hay tecnología que pueda resolver ninguna ecuación pedagógica. Pero el rol docente es también el rol que la sociedad le da, el cual se ha cuestionado y hasta despreciado. Esto no implica cuestionar las nuevas prácticas más horizontales y descentralizadas entre alumno y docente. Pero, ¿qué pasa si no les damos a los docentes las herramientas para resolver las cuestiones más básicas dentro del aula como la disciplina, los recursos, la capacitación? Sin esas herramientas, simplemente, no se puede desarrollar una actividad como la de enseñar y aprender.

"...pretendemos devolverle a la sociedad la confianza en la educación mediante el testimonio concreto de que más allá de dónde proviene cada uno, pasar por el nivel educativo mejora a la persona"

-Este planteo sobre el rol docente y la jerarquización, ¿traspasa lo instrumental del ámbito, es decir, usted pretende que sea también un mensaje a la sociedad?

-Yo insisto en la jerarquización en el sentido de que no podemos poner de cualquier manera un docente en un aula. Tenemos que brindarle las herramientas correctas en su formación, así como un contexto institucional. Para que se entienda: no es que no le podemos exigir al docente, pero los mensajes institucionales también están y son valiosos. Ambas cosas lo son. Siempre cuento la anécdota de (Domingo Faustino) Sarmiento sobre las “escuelas-palacio”, las escuelas con frontispicios de columnatas, con grandes inscripciones o alegorías en el frente del establecimiento. Cuando le preguntaban a Sarmiento por qué hacía semejante obra para una escuela, él decía “porque es el lugar más importante a donde cualquier niño argentino va a ir”. Pero cuando uno pasa de ese planteo a la escuela de container, como ha pasado, es muy difícil que alguien piense que ese es el lugar más importante al que va a ir en su vida. Y también, si todos creemos que los docentes tienen que ver solo con la huelga, estamos en un problema enorme. Si esto fuera cierto, sería una catástrofe, pero además de que no es cierto, necesitamos a los docentes en forma indispensable para construir la sociedad que viene. No escucho a nadie que diga que la educación no es importante, ahora ¿cuál es el esfuerzo que hacemos?

-La idea de huelga aparece de modo recurrente, pero siempre hay algo más fuerte que sustenta esas noticias, como un imaginario de crisis permanente. ¿A qué se debe ese sobrevuelo sobre la idea de “crisis en la educación”?

-Si solamente hay días de clase, no hay noticia. Pero si hay un día de paro, hay noticia, esto es así y no lo podemos negar. Pero también es cierto que la educación tiene otros tiempos: quien se inscribe en una universidad va a ver los resultados a los tres o cinco años. Y aunque para la educación sea desalentador aparecer en términos negativos, a nosotros, con la experiencia de la UNNOBA en la región, nos pasa exactamente al revés: en general somos una de las instituciones que mejores noticias vamos dando todo el tiempo, y esto tiene que ver con cómo nos acompaña la sociedad. Lo que vemos es que a nivel local la gente apoya la actividad de lo que siente como “su Universidad”, se siente muy orgullosa, y los medios de comunicación acompañan este proceso. Pero es cierto, también, que a nivel nacional lo educativo aparece como un sistema en crisis. Sobre esto Guillermo Jaim Etcheverry dice que cuando uno le pregunta a los padres por la educación de sus hijos, todos los padres dicen “tienen una buena educación”, y cuando le preguntan por la educación en general dicen que “es un desastre”. Entonces parece que solo los hijos de los otros van a esas escuelas o a ese sistema educativo en crisis. Como dice Jaim, ahí solo van los huérfanos.

-Está finalizando la inscripción para una tercera cohorte de la Escuela Secundaria. ¿Qué reflexión le merece el camino realizado?

-Que estamos y seguimos con el desafío que nos planteamos al inicio, pero ahora con 120 chicos en las aulas. No queremos ser una excepción para un reducido grupo, ni terminar replicando las prácticas que hay que modificar. Por supuesto que si todos los docentes vienen de esas prácticas, cae sobre ellos la responsabilidad de la innovación, de trabajar de otra manera, de tener otros resultados. Por supuesto que tienen la ventaja de tener una institución importante atrás, que los va a acompañar para que el resultado sea el que dijimos cuando abrimos el colegio: devolverle a la sociedad la confianza en la educación mediante el testimonio concreto de que más allá de dónde proviene cada uno, pasar por el nivel educativo mejora a la persona.

Fotos: Facundo Grecco

Edición de imagen: Laura Caturla

La Universidad hace escuela

Por Marcelo Maggio

En febrero de 2018 fue la inauguración. El flamante edificio aún dejaba resonar ecos de un vacío por llenar. De a poco la Escuela Secundaria perteneciente a la Universidad se puso en funcionamiento y, lejos de disminuir, las expectativas se hicieron cada vez mayores. La pregunta era por qué la Universidad se metía en ese terreno resbaladizo que es la educación media, llamando a los ojos de la ciudad de Junín y sus alrededores a posarse sobre este proyecto.

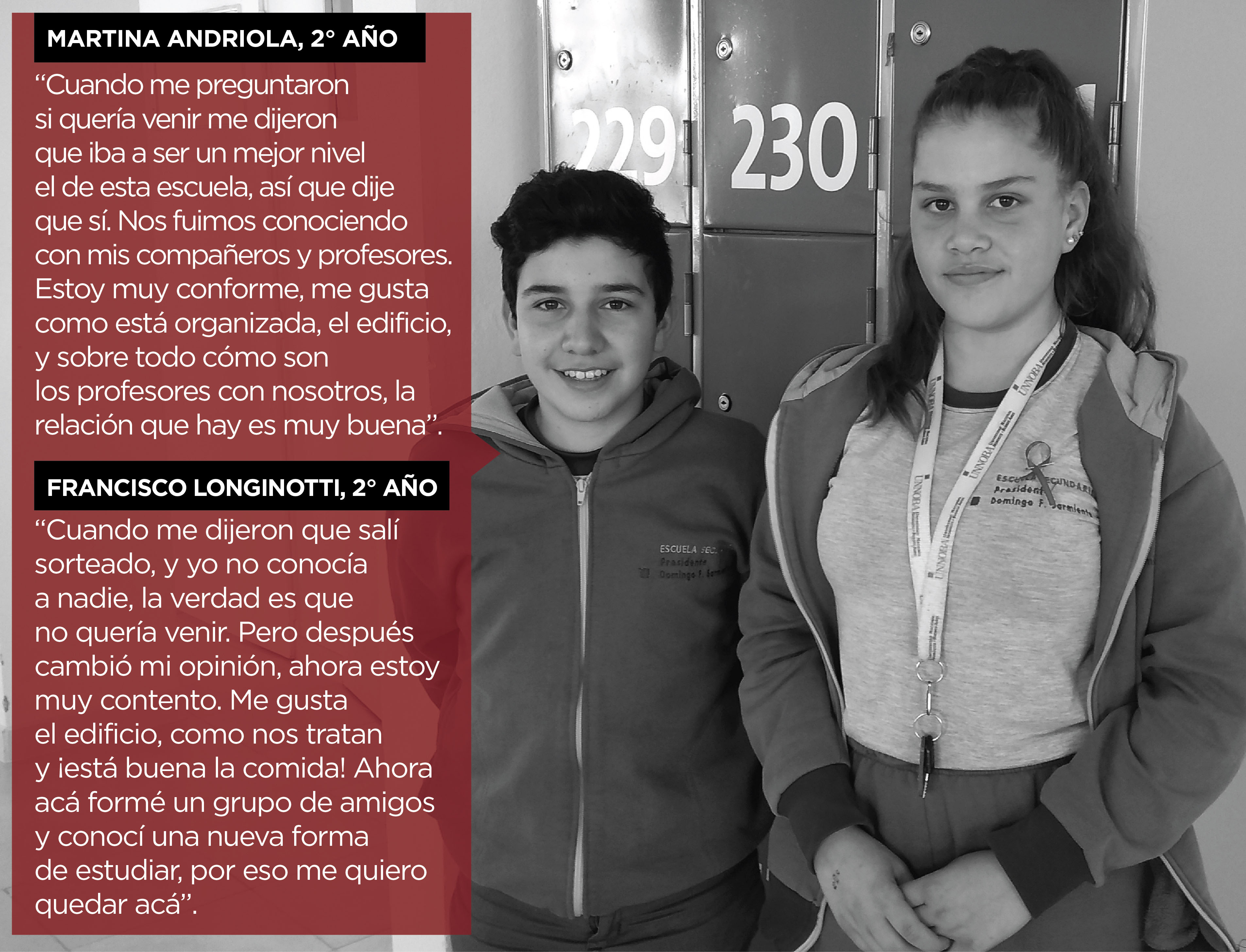

Está a punto de abrir la inscripción para una tercera cohorte y un tercer sorteo dirá quiénes ingresarán a la Escuela “Presidente Domingo Faustino Sarmiento”, que hoy cuenta con 120 estudiantes (dos comisiones de primer año y dos comisiones de segundo). Sus protagonistas tienen mucho para contar del camino recorrido desde aquella fiesta inaugural.

“Nosotros empezamos desde un lugar particular, que es el prestigio de la universidad en general y de la UNNOBA en particular, lo cual genera ciertas expectativas tanto en las familias como en los estudiantes”, admite Cristian Alonso, docente a cargo de los talleres de Educación Sexual Integral y Construcción de Ciudadanía. María Carolina García, profesora de Artes Visuales confiesa: “Cuando empezamos a trabajar tal vez estaban algunos miedos, pero quedaron atrás al ver los resultados. Ahora tenemos esa seguridad que te dan los padres cuando te hablan de los cambios positivos que notan en sus hijos, ¡eso te incentiva!”.

En lo académico y administrativo, la Escuela Secundaria es una unidad académica más de la Universidad. En palabras del profesor Alonso, esto le brinda cierta flexibilidad al proyecto, “desde las actividades hasta la planificación de contenidos, el desafío de la universidad es poder tomar las mejores experiencias y tradiciones de la escuela secundaria y desde nuestro proyecto ver qué experiencia universitaria podemos aportar”. “En un primer momento podemos decir que el trabajo por equipos de docentes hoy es una de las fortalezas de la escuela”, afirma.

En este sentido se expresa otra de las docentes, Fiorella Spinelli, de Ciencias Naturales, quien trabaja junto a Sofía Valla y Rodrigo Hernández del Pino. Para ella “es común trabajar en equipo porque la investigación es así”. Spinelli es becaria investigadora en el Centro de Investigaciones Básicas y Aplicadas de la Universidad (CIBA). Desde ese lugar explica que “la investigación va de la mano de la docencia, pero no siempre se da con estas edades, así que es un desafío”. “Me encanta por la creatividad que tienen los chicos, que quizás en el adulto no la encontrás, no la esperás, tienen salidas distintas y muy buenas”.

“Se busca despertar vocaciones científicas tempranamente y fortalecer la enseñanza de las ciencias básicas para generar una disposición hacia la ciencia”.

Ese trabajo por equipos abarca también la evaluación. “Entendemos que lo más valioso de nuestro sistema de evaluación es que es colegiado: el grupo completo de profesores y tutores evalúa a todos los alumnos. Esto nos permite tener una visión integral y no sólo saber algo del desempeño parcial en una asignatura, identificamos así cuáles son las fortalezas de los estudiantes y qué aspectos necesitan mejorar”. Quien detalla el sistema de evaluación es la profesora Juliana D'Andrea, coordinadora Académica de la Escuela.

En esa evaluación colectiva también participan los tutores, como Julio Sebastián De María, un tutor con formación en el profesorado de Matemática, quien explica su rol: “Nos reunimos con los docentes a evaluar juntos las competencias transversales como ‘pensamiento crítico’, ‘resolución de problemas’, ‘aprendizaje autónomo’, ‘comunicación y expresión’, ‘trabajo colaborativo’ y ‘ciudadanía democrática’”.

Los tutores pueden avanzar en este terreno debido al trabajo cotidiano tanto en el aula como fuera de ella. “Trabajamos de modo articulado con los profesores de las asignaturas como tutores académicos. Además, desde el equipo de tutores y junto al profesor del Taller, participamos en un espacio denominado ‘Construcción de juventudes y escuela’ en el que se desarrollan actividades relacionadas con la convivencia escolar, la valoración y respeto por la diversidad”. De María también destaca el rol de acompañamiento en el caso de que los estudiantes tengan problemas personales o conflictos: “Asumimos el diálogo como elemento central debido a que en esta escuela los chicos están en una jornada extendida y se pueden manejar otros tiempos, tanto para estudiar como para abordar temas de todo tipo”.

El sentido del trabajo de los docentes como un equipo pasa de la evaluación también a la generación de proyectos. María Carolina García, profesora de Artes Visuales, destaca uno de esos trabajos como una manera de articular su campo específico con los demás saberes: “Esta escuela tiene algo a su favor, que es trabajar a partir de la interdisciplina, abordar un tema no de manera aislada. Nuestras experiencias con proyectos demuestran que se puede tratar el conocimiento de manera más integral. Un caso muy lindo fue el que trabajamos con las docentes de Lengua, un proyecto sobre estereotipos de género que trabajaron ellas, y que desde nuestra materia lo vimos mediante la figura de Frida Kahlo y su arte”. Y desde el área de Lengua incorporaron la lectura de una colección sobre antiprincesas y antihéroes. “A partir de esa lectura, los estudiantes seleccionaron, investigaron y presentaron a sus compañeros una antiprincesa o un antihéroe local. Aparecieron así personas que llevan a cabo proyectos solidarios de la ciudad, o mujeres que realizan deportes más asociados a lo masculino, entre los variados ejemplos elegidos por ellos mismos”, comenta una de las docentes del área, María Silvia Biancardi.

Para Alonso el trabajo en equipos implica también desafíos básicos, como que no hay un docente por comisión para una asignatura sino que es “la pareja pedagógica la encargada, la asignatura se dicta en un mismo momento y los docentes van rotando. Se pone así en juego la libertad y creatividad de cada docente en cada momento”.

Ciencia y orientación de la escuela

La Escuela se orienta en Ciencias Naturales, algo que se va perfilando pero que a partir del ciclo superior (desde el cuarto año) define el tipo de materias a cursar y el perfil de egresado. Juliana D'Andrea explica que esta orientación “está en consonancia con el perfil de la Universidad”. “Se busca despertar vocaciones científicas tempranamente y fortalecer la enseñanza de las ciencias básicas para generar una disposición hacia la ciencia”. Sin embargo, detalla, “lo fundamental es que la Escuela trabaja para la formación integral de sus estudiantes, con un fuerte componente humanista, que se refleja no sólo en la carga horaria destinada a espacios como Lenguas Extranjeras, Ciencias Sociales o Lengua, sino también en la variedad de actividades culturales y artísticas que se realizan periódicamente”.

Fiorella Spinelli, desde el área de Ciencias Naturales, destaca cómo se puede fomentar el pensamiento científico y la metodología científica ya desde la temprana edad: “Fomentamos la realización de investigaciones, ya sean bibliográficas o prácticas. Esa es una estimulación científica: tener un problema y pensar cómo resolverlo. Por ejemplo, se les da un ser vivo desconocido y ellos tienen que simular que son científicos y clasificarlo. Entonces deben crear e imaginar experimentos para clasificar a ese ser vivo, presentar las conclusiones y defenderlas ante el resto de la clase. No se trata de memorizar la taxonomía que les digamos nosotras, sino tratar de pensar y encontrar un camino. Así no solo lo resuelven, sino que también salen cosas muy divertidas”.

“La Escuela trabaja para la formación integral de sus estudiantes, con un fuerte componente humanista, que se refleja en la variedad de actividades culturales y artísticas que se realizan periódicamente”.

Entre los recursos para la investigación se encuentran los laboratorios de experimentación. “Se trabaja mucho en el laboratorio -comenta Spinelli-. Se hacen actividades como en otras escuelas pero con un complemento que es el laboratorio”. Uno de los experimentos que recuerda con mayor impacto es el de observación con el microscopio: “Se miran los taxismos (movimientos) de paramecios (organismos microscópicos que habitan el agua) en base a estímulos. Un paramecio se puede encontrar en el agua estancada y allí, por ejemplo, si se pone azúcar, los paramecios van hacia el estímulo; en cambio si se les pone sal, se alejan”. Spinelli destaca que así se puede acceder de otra manera a una teoría como “la función de relación de los seres vivos”, siempre teniendo en cuenta que “los experimentos se deben adecuar a la edad de los alumnos”, teniendo en cuenta tanto la comprensión como los niveles de seguridad.

La vida académica y laboral está cada vez más imbricada con el idioma inglés. Pilar Traverso, secretaria Académica de la Universidad, tuvo a su cargo la propuesta curricular del área de Lenguas Extranjeras y puntualizó que para la elección del estudio de esta lengua "se tuvieron en cuenta los cambios lingüísticos ocurridos en el mundo y la metodología y didáctica de lenguas en general". Agrega un dato muy significativo y es que ha crecido sustancialmente el número de personas que hablan inglés como lengua extranjera, tanto que la utilizan como una lengua vehicular o de comunicación “universal" una cantidad de personas que supera a sus hablantes nativos.

El contenido en lenguas extranjeras se trabaja mediante una metodología de "aprendizaje integrado de contenidos". Este enfoque pone énfasis en usar la lengua extranjera para la resolución de problemas de otras áreas del conocimiento. El objetivo es doble: permitir a los estudiantes adquirir conocimientos en distintas áreas y hacerlo mediante el desarrollo de una competencia en lengua extranjera. Traverso indica que en esta metodología "hay dos objetos de aprendizaje: el lingüístico y el no lingüístico, sin predominio de uno sobre otro".

Lograr aptitudes de comunicación eficaces forma parte de los objetivos tradicionales. Pero desde la escuela consideran también central la posibilidad de "adquirir conocimientos de diferentes áreas y aptitudes para el aprendizaje" desde otra lengua. "También hay objetivos socioculturales: la transmisión de valores de respeto por las diferencias, y socioeconómicos, la preparación para la vida en una sociedad internacional y para mejorar las perspectivas de inserción en el mundo del trabajo", agrega la secretaria Académica de la UNNOBA.

Convivencia y jornada extendida

En la Escuela Secundaria de la UNNOBA la jornada es extendida, ya que de lunes a viernes los estudiantes están de 7.30 a 16.30. En ese marco, desayunan y almuerzan en la institución con un menú diseñado por una profesional en función de las necesidades nutricionales propias de la edad, y también teniendo en cuenta exámenes de salud. A la jornada también se le suman dos colaciones. Este servicio de comedor se garantiza mediante el “Sistema Solidario de Aportes y Beneficios” que está compuesto por dos tipos de aportes: el aporte institucional y el aporte familiar. Al momento de la confirmación de la vacante, las familias suscriben una carta compromiso, y aquellas que lo necesitan solicitan un beneficio de eximición del 50 o el 100% del aporte familiar.

Al ser una gran cantidad de horas, sumadas a las jornadas y talleres que se realizan los días sábados, la convivencia resulta un factor fundamental sin el cual no sería posible avanzar en terreno sólido. En este sentido Juliana D'Andrea plantea: “Pensamos que la convivencia es un elemento central de la Escuela así como también una instancia de aprendizaje más. La convivencia no se trata simplemente de cumplir normas. Transmitimos la importancia de construir democráticamente los acuerdos de convivencia con la participación de todos los actores de la comunidad escolar y para pensar la escuela en términos colectivos”.

En este sentido, la convivencia implica pensar la escuela como un lugar donde se escucha, donde se piensa al estudiante como un sujeto de derecho. Y en esto coinciden todos los docentes, se intenta que el cumplimiento de las pautas sea por convicción, por asumir que son las normas que benefician a todos y no algo antojadizo. Aquí también coinciden con otras escuelas del nivel medio, en la tendencia generalizada a implicar a los alumnos en ciertas decisiones, con la certeza de que cualquier situación social necesita reglas, y la convicción es la mejor forma de hacer realidad la convivencia.

Abordar las situaciones problemáticas desde lo que significa la adolescencia en sí, su particularidad emocional, es lo específico para cualquier escuela secundaria. Para ello hay estrategias y modos: “También tenemos que partir desde lo afectivo, que es algo que tiene la dimensión de la convivencia para, desde ahí, trabajar lo pedagógico”, reflexionan desde la Escuela de la UNNOBA.

Educar para tiempos diversos

La enseñanza secundaria enfrenta un desafío actual, que es asumir la diversidad de los estudiantes, y cambiar la posición tradicional que partía de pensar solamente desde la instancia de la enseñanza. “Partir desde el aprendizaje es no pensar ‘cuál es la clase que quiero dar’ sino imaginar ‘cuál es la clase que necesitan cada uno de mis estudiantes’”, explica Alonso. Ahí radica la complejidad de la tarea y es por eso que resulta un desafío no para un docente aislado sino para un grupo o colectivo docente.

Esa tensión que plantea el aprendizaje entre lo homogéneo y lo diverso es puesta en juego también por el modo de ingreso que tiene la Escuela, que es el sorteo. “Desde la teoría y desde la convicción intentamos generar un modelo pedagógico en el que el acontecimiento educativo gravite en torno a lo que el estudiante necesita, no trabajar con modelos ideales sino con los estudiantes reales. La diversidad es positiva y complejiza la tarea docente”, es una idea que atraviesa la charla con los docentes, encontrar esa conexión con la complejidad social.

“La diversidad en el aula es siempre un desafío, sobre todo para que la escuela no se configure en una tradición elitista de una educación para los mejores sino en algo plural y diverso”, indican. Ese es el espíritu que recorre a esta escuela desde su fundación, y que debe renacer año a año, al ritmo de los desafíos que le imponen los ojos vidriosos de quienes van llegando con una carga de ilusión en cada sorteo y en cada ingreso.

Las aguas bajan por el Salado

La foto del chalet vista desde el cielo tenía el efecto de la elocuencia. Rodeado por el agua de la laguna de La Picasa no dejaba lugar las dudas: “¿Alguien hace chalets en el medio de una laguna?”, se preguntó con voz entrecortada el productor agropecuario. “Por culpa de estos desmanejos se inundaron no solo casas como ésta, a 14 km de la laguna, sino también los campos”, sentenció. Sin embargo, y ante la evidencia, la respuesta del funcionario público no se hizo esperar: “Las zonas de afectación que tiene una laguna son zonas de riesgo hídrico, esto significa que cada uno de los productores sabe que está dentro de una zona que se puede inundar”.

El agua en la zona de llanura puede ser la bendición que permite crecer a todo tipo de ser vivo o puede ser la amenaza latente que, sin control ni orden, barre con todo lo que se le ponga en frente, sin pedir permiso y, sobre todo, a una velocidad en la que la respuesta humana resulta inútil. Es por eso que frente al escenario de la laguna La Picasa se pueden dar debates, pero también aprendizajes, como el que se intentó brindar en la jornada Manejo Racional de las Cuencas Hídricas La Picasa y Río Salado, que convocó a productores, funcionarios e investigadores, todos relacionados y preocupados por la situación hídrica actual de ambas cuencas.

Esta jornada fue organizada por la UNNOBA y Honorable Senado de la Provincia de Buenos Aires, a través del senador Gustavo Traverso.

“Cuenca endorreica”

La cuenca de la Laguna de La Picasa es cerrada, es decir que no tiene una salida propia y natural por la superficie. Es por ese motivo que viene creciendo desde el año 1995, cuando el régimen de lluvias creciente la colapsó, y la sigue haciendo crecer sin parar. Solo entre 2004 y 2008 hubo años de calma, pero el resto de los años las lluvias superaron la media. La acumulación de agua en las lagunas de la cuenca y el ascenso de los niveles freáticos, es decir la acumulación de líquido en el subsuelo, hicieron que no solo los productores y habitantes se vieran afectados: en 2017 la Ruta Nacional N°7 fue superada por el nivel acuático, lo que produjo el corte que se mantiene hasta hoy. El ferrocarril sufrió el mismo destino a causa del desborde.

"En el año 1988 la laguna ocupaba 3 mil hectáreas. En el 2001, un período crítico, fueron 40 mil hectáreas"

Aunque la Cuenca de la laguna La Picasa es administrada por un comité, creado por voluntad de las provincias de Córdoba, Santa Fe y Buenos Aires, fue ratificado por leyes provinciales, y tuvo el tratamiento de una ley nacional que lo avala, el organismo sigue sin arribar a las soluciones y a un enfoque consensuado del problema. Desde el área técnica del Comité de Cuenca se debaten las salidas, y cada provincia tiene sus representantes con sus propuestas, muchas de ellas detenidas por motivos financieros y otras por motivos no enunciados. Y el cruce analítico La Picasa-Río Salado brindado en la jornada universitaria no fue casual. En abril de este año un medio de Junín alertaba: “Entró en funcionamiento un nuevo canal en La Picasa y llegará mucha más agua a Junín”(1). Pero, ¿es así? El debate de la jornada abordó detalles que harían pensar lo contrario. Más allá de los puntos de vista legales y técnicos, el agua ya está escurriendo por ese canal anunciado en abril y en la práctica ya se vislumbra el asfalto de la ruta nacional que, sin tránsito, muestra su raquítica pero valiosa estructura.

“Alternativa norte”

Juan Carlos Bertoni es el secretario de Recursos Hídricos de la provincia de Santa Fe. En el Auditorio del Bicentenario de la sede Junín de la UNNOBA no dudó en calificar a la compuerta inaugurada en abril como el “Mercedes Benz de las obras”, ya que cuenta con tecnología de punta, como el monitoreo remoto del caudal hídrico. Y no dudó en advertir la gravedad de la situación y la necesidad de actuar: “En el año 1988 la laguna ocupaba 3 mil hectáreas. En el 2001, un período crítico, fueron 40 mil hectáreas. Su cota, esto es la altura del agua sobre el nivel del mar, llegó a 105 metros. Tanto el ferrocarril como la ruta habían quedado totalmente inmersos en la laguna. Hoy la cota está alrededor de los 103 metros, y va cambiando todos los días”.

La altura de la cota es un número que tanto productores como funcionarios siguen atentos todos los días, ya que es el signo de alarma para intervenir. Como referencia informaron: la altura de las vías del ferrocarril está a 104,5 metros sobre el nivel del mar y la Ruta Nacional 7 en los 104,8 metros. Bertoni recordó que hacia octubre de 2017, momento crítico, se llegó a una cota de 105,78 “por lo que la laguna estaba con 1 metro de agua por arriba de la infraestructura, ni hablar de los campos”.

Bertoni explicó la decisión tomada: “En el año 2017 la provincia de Santa Fe, ante el comité interjurisdiccional, presentó la propuesta de ejecutar una alcantarilla, es decir un instrumento que escurre por gravedad, sin bombeo. El agua va desde La Picasa hasta Teodelina en territorio santafesino, donde se colocó esta compuerta”. Y agregó: “¿Qué se ha ejecutado? Cuando se supera la cota de 102,7 metros hay una salida de emergencia mediante una alcantarilla, que saca el agua de la laguna y la lleva al nivel apropiado”. La longitud del canal de tipo "by pass" es de casi 2400 metros.

Desde el punto de vista del escurrimiento por gravedad (y no por bombeo, que podría implicar un caudal constante) esta salida de emergencia no sería permanente y dependería del nivel de cota, contribuyendo al descenso del nivel de la laguna. “La alcantarilla, al ser una salida controlada solo para situaciones de emergencia, no puede generar problemas”, indicó Bertoni, aclarando que el caudal máximo de esa salida de emergencia de La Picasa es de unos 5 metros cúbicos por segundo, algo relativamente escaso en relación al caudal de la cuenca del Salado. “Felizmente en esta alcantarilla, que tiene compuerta y una estación de monitoreo, todas las provincias pueden controlar el caudal y el nivel, y siempre está la posibilidad de cerrarla mediante un protocolo de manejo”, destacó.

¿Qué sabe el agua de política?

El ingeniero Marcelo Rastelli es director técnico de la Dirección provincial de Hidráulica del Ministerio de Infraestructura de la provincia de Buenos Aires y aportó posicionamientos no sólo acerca de La Picasa sino también, y como “contraejemplo”, sobre las obras del “Plan Maestro Integral de la Cuenca del Río Salado”. Destacó la importancia de este Plan ya que “incorpora áreas propias y áreas anexas y permite así abordar el tratamiento de una superficie total de 17 millones de hectáreas, constituyéndose en el área de estudio y desarrollo más importante de la provincia de Buenos Aires”, donde viven alrededor de 2 millones de habitantes y se concentra el 30% de la producción nacional de granos y de carne.

“La variabilidad hídrica -indicó- nos expone a conflictos de interés entre los diferentes usuarios de la cuenca. Los productores, las actividades recreativas, la pesca, el turismo, las actividades académicas, las organizaciones no gubernamentales, y el Estado que administra... se ponen de manifiesto”.

En relación al Plan, eligió hacer un balance positivo y destacó: “Tenemos más de la mitad del río (Salado) con obras terminadas o en ejecución. Pero también el plan propone la ejecución de nuevos canales troncales que permitan densificar esta red de captación de excedentes y conectarlos a vías de evacuación para proteger las ciudades”. Su énfasis estuvo puesto en que las intervenciones de infraestructura de este tipo, cuando se trata de integrar un territorio tan vasto, solo pueden ser exitosas en la medida en que se cuente con una capacidad de manejo “resultado de acuerdos que alcancen a todos los usuarios de la cuenca”. Y con la idea fuerza de relacionar manejo y acuerdo miró fijamente hacia la provincia de Santa Fe.

“La provincia de Buenos Aires tiene la voluntad de recibir los excedentes de agua que reduzcan los efectos de la inundación en La Picasa, pero entendemos que se deben dar una cantidad de recaudos que nos den garantía. Para esto el denominado canal alternativa norte y las obras de conexión que ha efectuado Santa Fe deben tener mecanismos de control y manejo más eficaces que lo hecho hasta ahora”. Para el ingeniero Rastelli este canal, que está traspasando alrededor de 5 metros cúbicos de agua actualmente, “está conectado de un modo irregular”, porque no se partió de acuerdos comunes.

Rastelli señaló que desde el punto de vista de una cuenca, La Picasa abarca o implica unas 500 mil hectáreas en un territorio que involucra a tres provincias. “La cuenca es la extensión de territorio que contribuye a un cuerpo de agua. En este caso una cuenca cerrada y endorreica como La Picasa solo fue identificada como tal hasta mediados de los años 90 y por eso se constituyó en 1998 un Comité de Cuenca”.

Con mucha rapidez se desarrollaron estudios que permitieron contar con un mejor conocimiento de esta “nueva cuenca”, incluso se llegó al planteo de soluciones, y se concluyó que la autorregulación natural que tuvo La Picasa durante tantos años llegaba a su fin debido al incremento de “las expectativas del uso del suelo que tienen los pobladores”, sobre todo en lo relacionado a la agricultura.

Por lo tanto era necesario pasar a la acción mediante obras de infraestructura: ordenar el escurrimiento interno de la cuenca era una necesidad, pero también disponer de elementos de retención. La capacidad de exportación o retención del agua permite sostener el balance en los niveles de fluctuación, tanto en sequía como en abundancia.

Desafortunadamente para los pobladores de la cuenca, el Comité no tuvo el rol esperado y hubo acciones sin coordinación, lo que llevó a que la provincia de Buenos Aires lleve ante la Justicia las acciones de infraestructura de Santa Fe, con posiciones claramente encontradas. “En mi modesta opinión, todo se hizo al revés”, se lamentó Rastelli.

Datos reveladores

Eduardo Kruse, director del Centro De Investigaciones y Transferencia del Noroeste de la Provincia de Buenos Aires (CITNOBA), puso en escena otros factores a tener en cuenta, como el rol del agua subterránea y la necesidad de una perspectiva de construcción histórica en estos fenómenos, que deben ser estudiados con atención una vez que se los interviene.

“Desde nuestro punto de vista, para considerar un manejo racional del agua en cuencas hídricas en una llanura también hay que tener en cuenta los movimientos verticales del agua, es decir a la evaporación y a la infiltración, y no solo el escurrimiento superficial”, advirtió, ya que todo el debate en las actuales condiciones incluye las obras de drenaje o retención del movimiento horizontal del agua.

Kruse se preguntó por la interacción que hay entra aguas superficiales y aguas subterráneas: “Muchas veces al no ver lo que ocurre en el subsuelo se simplifica su importancia en el funcionamiento hidrológico de una llanura”.

“Las divisorias de agua son difusas”, volvió a advertir. “Esto se asocia con lo climático y a que estamos en una región que responde a lo árido, a una formación arenosa que tiene su origen hace unos 7 mil años en la zona pampeana, con bajas precipitaciones y altas temperaturas, eso generó un paisaje de mantos arenosos que todavía no se han adaptado a la condición húmeda actual”.

Claro que es esta condición árida, sin la cantidad de canales, ríos y lagunas de retención suficientes, la que se trata de modificar a través de las obras de infraestructura, aunque hay que asumir los riesgos de “acelerar lo que naturalmente tendría que producirse con los años”.

El investigador de la UNNOBA recordó que ya en 1884 Florentino Ameghino planteó en un trabajo la idea de no sólo producir drenaje para las inundaciones, si no también que las llanuras requieren del manejo de agua para los tiempos de sequía. “Ameghino es quien plantea uno de los primeros conceptos acerca del manejo racional del agua en un área de llanura”, dijo Kruse ante el Auditorio.

Los datos sobre la abundancia de agua actualmente son elocuentes: si hacia la década de 1940 los trabajos citan niveles de 10 o 12 metros de profundidad freática, “actualmente el agua está muy próxima a la superficie, a 2 o 3 metros”. Cuando el ascenso de los niveles freáticos alcanza la superficie se produce el “afloramiento del agua” y empiezan a aparecer las zonas anegadas, al que se puede sumar el otro fenómeno, el de la falta de escurrimiento en superficie, aumentando así el problema de la inundación.

Si bien el dato aportado por Kruse llevó intranquilidad a un escenario de por sí cargado de tensión, el involucramiento y la presencia de la Universidad permitió unificar la mirada hacia el futuro: “El concepto de manejo sustentable supera la cuestión meramente técnica para encontrarse con otros elementos, actores sociales, políticos, académicos y económicos”, insistió para motivar el diálogo.

En concreto la Universidad está desarrollando proyectos relacionados específicamente con la zona y tendientes a lograr precisiones para evaluar adecuadamente la interacción entre agua superficial y agua subterránea y conocer mejor los procesos naturales y su reacción frente a las actividades humanas en relación al recurso agua. Son tres proyectos específicos que destacó Kruse: experiencias hidrológicas piloto en el Campo Experimental de la UNNOBA en Junín; también la vinculación de ecología y monitoreo de ambientes acuáticos pampeanos, relacionados con las áreas lacustres de la cuenca del Salado; y un desarrollo de un sistema de soporte de las decisiones frente a eventos extremos en la gestión de la cuenca del río Salado en la provincia.

En este sentido el rector de la UNNOBA, Guillermo Tamarit, destacó ya en el cierre de la jornada: “Nos gusta que en esta casa se puedan desarrollar debates, plantear temas que van atravesando las distintas dimensiones de nuestra sociedad. La universidades somos el ámbito natural para las discusiones de este tipo y respecto a este tema en particular nuestra Universidad tiene un rol importante en dos espacios que son de los más importantes desde lo científico tecnológico en la provincia de Buenos Aires. Uno es el Sistema Integrado de Monitoreo y Alerta Temprana Hidroambiental (SIMATH), que integramos junto al Ministerios de Ciencia y Tecnología de la Provincia, la comisión de investigaciones científicas y ocho universidades nacionales del interior de la provincia de Buenos Aires. Esto en una provincia que tiene problemas desde desertificación hasta inundaciones, donde todas estas cuestiones van siendo atrapadas por conflictos que llegan al nivel científico, porque hay una recurrencia en apelar a las universidades para las respuestas técnicas a medida que satisfacen los intereses particulares y no las mejores soluciones técnicas. Por esto es que hay que mediar”. “Ahora si nos preguntan cuál es el interés que nosotros pretendemos preservar, es el interés del futuro, es decir el interés de los que vienen, y sin duda tiene que ver con el legado que como institución y como padres tenemos que ofrecer”, insistió Tamarit.

Por Marcelo Maggio

Nota:

(1) Junín Digital: "Entró en funcionamiento un nuevo canal en la Picasa y llegará mucha más agua a Junín"

Cuando lo virtual es lo real

Por Marcelo Maggio

Cuando Guillermo Simari visitó la UNNOBA para hablar del “futuro inmediato de la informática”, tal vez hubiera alguien esperando un viaje por las últimas ferias de novedades, como la Google I/O o el E3 de Los Ángeles (1). Pero no.

El docente de la Universidad Nacional del Sur (Bahía Blanca) eligió introducir al auditorio con una afirmación más general: “Tenemos hambre de cuentos. ¿Cuánto tiempo dedica nuestra sociedad a los cuentos? Es como una droga y eso nos ha llevado a la creación de bibliotecas”. De hecho de uno de esos cuentos, Neuromante, surgió la palabra “ciberespacio”. Anclados en la ficción, pero con los pies en el presente, Simari dispara: “La realidad virtual es una extensión de esta realidad y ya no se la puede pensar por separado”.

En el significativo año 1984, cuando el escritor William Gibson acuñaba el ciberespacio, sólo la ciencia ficción podía habitar de esa manera lo virtual, y la pregunta “¿esto es real o virtual?” aún no aparecía como un verdadero dualismo de la era de las computadoras. Pero luego el ciberespacio como metáfora se extendería más allá en el pensamiento y llegaron quienes se preguntaron “¿vivimos dentro de una simulación de computadoras?”, como lo hicieron los cultores del film The Matrix (1999); o también, más acá en el tiempo, “¿es posible descubrir las raíces profundas de lo real o es todo una posverdad, un escenario creado por los media?”. En el mundo de las simulaciones, la realidad virtual parece ser algo más que una simple cuenta en una red social.

“Se interactúa continuamente con lo virtual, por eso no es que tenemos dos realidades separadas: hay una única realidad”, insiste el docente, y el auditorio que lo sospechaba ya comienza a ver el enfoque.

Desde las formulaciones de Francis Bacon (siglo XVII) en adelante, hay un acuerdo en que la percepción sensorial es fundamental para la experiencia del conocimiento: lo real es lo tangible, es decir, lo que se puede percibir con todos los sentidos humanos. Pero ahora hay otra parte de lo real a la que los humanos solamente tenemos acceso si disponemos de un dispositivo electrónico. Al complejo de sentidos humanos se lo denomina sensorium, y la crisis aparece en este punto: hay cosas del mundo que el sensorium ya no percibe, ergo necesitamos algo más para acceder a la realidad.

"No estar conectado ya es como estar ciego. Si a uno le dicen que tiene que estar ciego tres horas por día, ¿lo toleraría?"

La verdadera tendencia, para Simari, es la “conexión más directa con esta nueva realidad porque es una necesidad”. “Cuando uno se queda sin el dispositivo para acceder a lo virtual, como puede suceder en un avión, uno se siente separado. Simplemente no poder acceder por una situación normal como volar no es tolerado. Ese avance continuo de la conectividad va a tener una connotación, que es la conexión directa. No estar conectado ya es como estar ciego. Si a uno le dicen que tiene que estar ciego tres horas por día, ¿lo toleraría?”.

Pero, ¿cómo podría ser esa conexión más directa con la realidad? ¿Acaso no sobra conectividad con la tecnología actual? Parece que no, y la falta de conectividad se puede expresar en males como la “nomofobia”, definida como “miedo irracional a no disponer del teléfono”. La palabra es un acrónimo de la expresión “no-mobile-phone phobia”. Simari no cree que sea algo irracional la nomofobia, porque “se ha creado una parte del mundo a la cual solo podemos acceder si disponemos del teléfono”.

“Hoy el miedo a perder la conectividad es el miedo que puede sentir un animal al ser separado de su manada, es estar solo en el mundo, un resultado agresivo hacia nosotros. Este miedo a no estar conectado no es ninguna locura”, sostiene Simari.

"Uno se mete en el mundo digital e interactúa con cosas que sólo existen ahí. Eso es la realidad virtual..."

Acaso la fusión entre realidades (¿material y virtual?) ya la estaba anunciando el propio Gibson en el inicio de Neuromante, donde se lee: El cielo sobre el puerto tenía el color de una pantalla de televisor sintonizada en un canal muerto.

“Uno se mete en el mundo digital e interactúa con cosas que sólo existen ahí. Eso es la realidad virtual, pero ¿qué pasa cuando para acceder al mundo digital hay que anular un sentido en el mundo real, como con los lentes de realidad virtual? Aunque no es la solución definitiva, están ahí”, indica Simari.

“Creo que la realidad aumentada es un poco mejor, porque no anula la visión sino que complementa los sentidos que ya tenemos. La forma de acceder es complementaria”, considera. La realidad aumentada es un conjunto de tecnologías que permiten “ver el mundo” desde un dispositivo que añade y enriquece con información virtual lo que vemos en la ¿lisa? realidad sensorial.

Uno de esos dispositivos podrían ser los lentes de Google, tanto en su versión original, desbordante de aparatosidad analógica, como en los prototipos que se imaginan para dentro de un momento: lentes de contacto con conexión a internet que brindan información en tiempo real de todo lo que vemos, cual Terminator, pero en tiempos de paz.

Perfil. Guillermo Simari es Profesor Emérito de la Universidad Nacional del Sur (UNS). Doctor of Science (Ph.D.) por la Washington University. Licenciado en Matemática por UNS. Es fundador en 1992 del Grupo de Investigación en Inteligencia Artificial (GIIA) y desde el año 2000 del Laboratorio de Investigación y Desarrollo en Inteligencia Artificial. Fue decano del Departamento de Ciencias e Ingeniería de la Computación de la UNS y ha publicado sus trabajos en revistas científicas y editoriales de todo el mundo.

***

Cuando Friedrich Nietzsche utilizó la expresión “demasiado humano” definitivamente no estaba pensando en un cyborg (organismo cibernético) o en la idea de prótesis maquínica. De todos modos aportó una serie de preguntas que siguieron abriendo la herida narcisista de la humanidad, tal como lo hizo Darwin o Freud. La herida no sanó jamás y ahora surge la pregunta muy a pesar de Nietzsche, ¿si no hubiera más humano y éste ya fuera otra cosa?

Aparecen así los debates sobre posthumanismo y transhumanismo, la hibridación hombre-máquina y la expansión de las facultades sensoriales, ya no sólo por los dispositivos, sino también por la potencialidad de la inteligencia artificial (IA). Y frente a un escenario de posible evolución de la especie aparecen también las preguntas éticas.

“Hoy en día hablar de dispositivos electrónicos y no hablar de inteligencia artificial es dejar la mayor parte del desarrollo afuera. No hay una posibilidad de separar la IA de la informática. De hecho es la parte más novedosa y más efectiva de la informática”, afirma el docente.

"si uno lograra desarrollar lo que se llama ‘inteligencia artificial general’, ¿qué pasa con ese dispositivo?, ¿qué derechos tenemos nosotros sobre ese ‘individuo’ que hemos creado y que es ‘casi como’ un ser humano?"

Hace unos setenta años, después de culminada la Segunda Guerra Mundial, el matemático Alan Turing había propuesto un simple test que imaginaba un desafío: si un humano tenía un diálogo con una máquina que se hiciera pasar por una persona, y el humano no podía determinar después de la charla si había hablado con un humano o una máquina, entonces se habría alcanzado un umbral de inteligencia artificial. El test se popularizó y es un hito en la historia de la informática, pero desde ahí hasta ahora, ¿no ha habido una sobrevaloración de la posibilidad de la inteligencia maquínica?