Cuando lo virtual es lo real

Por Marcelo Maggio

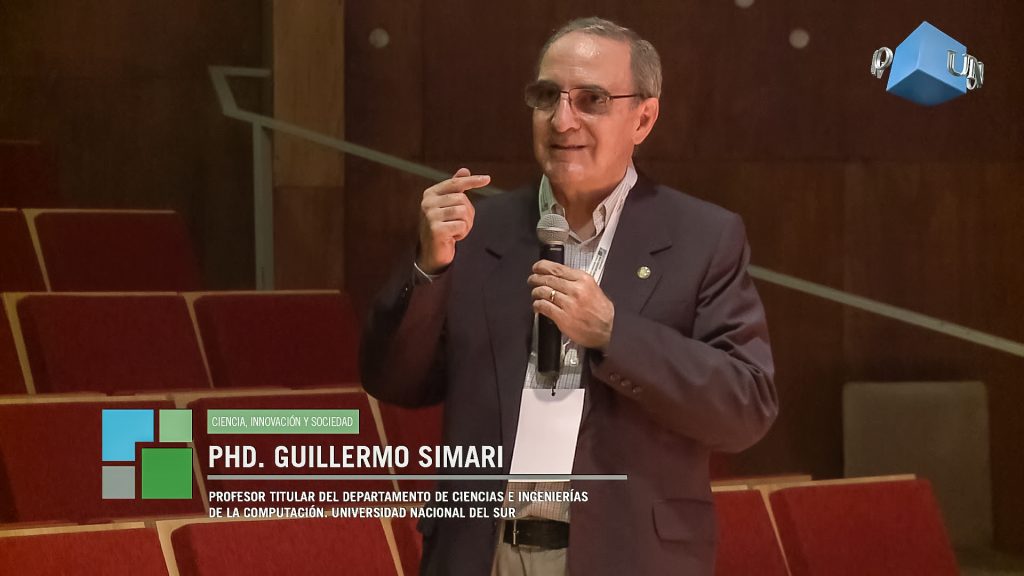

Cuando Guillermo Simari visitó la UNNOBA para hablar del “futuro inmediato de la informática”, tal vez hubiera alguien esperando un viaje por las últimas ferias de novedades, como la Google I/O o el E3 de Los Ángeles (1). Pero no.

El docente de la Universidad Nacional del Sur (Bahía Blanca) eligió introducir al auditorio con una afirmación más general: “Tenemos hambre de cuentos. ¿Cuánto tiempo dedica nuestra sociedad a los cuentos? Es como una droga y eso nos ha llevado a la creación de bibliotecas”. De hecho de uno de esos cuentos, Neuromante, surgió la palabra “ciberespacio”. Anclados en la ficción, pero con los pies en el presente, Simari dispara: “La realidad virtual es una extensión de esta realidad y ya no se la puede pensar por separado”.

En el significativo año 1984, cuando el escritor William Gibson acuñaba el ciberespacio, sólo la ciencia ficción podía habitar de esa manera lo virtual, y la pregunta “¿esto es real o virtual?” aún no aparecía como un verdadero dualismo de la era de las computadoras. Pero luego el ciberespacio como metáfora se extendería más allá en el pensamiento y llegaron quienes se preguntaron “¿vivimos dentro de una simulación de computadoras?”, como lo hicieron los cultores del film The Matrix (1999); o también, más acá en el tiempo, “¿es posible descubrir las raíces profundas de lo real o es todo una posverdad, un escenario creado por los media?”. En el mundo de las simulaciones, la realidad virtual parece ser algo más que una simple cuenta en una red social.

“Se interactúa continuamente con lo virtual, por eso no es que tenemos dos realidades separadas: hay una única realidad”, insiste el docente, y el auditorio que lo sospechaba ya comienza a ver el enfoque.

Desde las formulaciones de Francis Bacon (siglo XVII) en adelante, hay un acuerdo en que la percepción sensorial es fundamental para la experiencia del conocimiento: lo real es lo tangible, es decir, lo que se puede percibir con todos los sentidos humanos. Pero ahora hay otra parte de lo real a la que los humanos solamente tenemos acceso si disponemos de un dispositivo electrónico. Al complejo de sentidos humanos se lo denomina sensorium, y la crisis aparece en este punto: hay cosas del mundo que el sensorium ya no percibe, ergo necesitamos algo más para acceder a la realidad.

“No estar conectado ya es como estar ciego. Si a uno le dicen que tiene que estar ciego tres horas por día, ¿lo toleraría?”

La verdadera tendencia, para Simari, es la “conexión más directa con esta nueva realidad porque es una necesidad”. “Cuando uno se queda sin el dispositivo para acceder a lo virtual, como puede suceder en un avión, uno se siente separado. Simplemente no poder acceder por una situación normal como volar no es tolerado. Ese avance continuo de la conectividad va a tener una connotación, que es la conexión directa. No estar conectado ya es como estar ciego. Si a uno le dicen que tiene que estar ciego tres horas por día, ¿lo toleraría?”.

Pero, ¿cómo podría ser esa conexión más directa con la realidad? ¿Acaso no sobra conectividad con la tecnología actual? Parece que no, y la falta de conectividad se puede expresar en males como la “nomofobia”, definida como “miedo irracional a no disponer del teléfono”. La palabra es un acrónimo de la expresión “no-mobile-phone phobia”. Simari no cree que sea algo irracional la nomofobia, porque “se ha creado una parte del mundo a la cual solo podemos acceder si disponemos del teléfono”.

“Hoy el miedo a perder la conectividad es el miedo que puede sentir un animal al ser separado de su manada, es estar solo en el mundo, un resultado agresivo hacia nosotros. Este miedo a no estar conectado no es ninguna locura”, sostiene Simari.

“Uno se mete en el mundo digital e interactúa con cosas que sólo existen ahí. Eso es la realidad virtual…”

Acaso la fusión entre realidades (¿material y virtual?) ya la estaba anunciando el propio Gibson en el inicio de Neuromante, donde se lee: El cielo sobre el puerto tenía el color de una pantalla de televisor sintonizada en un canal muerto.

“Uno se mete en el mundo digital e interactúa con cosas que sólo existen ahí. Eso es la realidad virtual, pero ¿qué pasa cuando para acceder al mundo digital hay que anular un sentido en el mundo real, como con los lentes de realidad virtual? Aunque no es la solución definitiva, están ahí”, indica Simari.

“Creo que la realidad aumentada es un poco mejor, porque no anula la visión sino que complementa los sentidos que ya tenemos. La forma de acceder es complementaria”, considera. La realidad aumentada es un conjunto de tecnologías que permiten “ver el mundo” desde un dispositivo que añade y enriquece con información virtual lo que vemos en la ¿lisa? realidad sensorial.

Uno de esos dispositivos podrían ser los lentes de Google, tanto en su versión original, desbordante de aparatosidad analógica, como en los prototipos que se imaginan para dentro de un momento: lentes de contacto con conexión a internet que brindan información en tiempo real de todo lo que vemos, cual Terminator, pero en tiempos de paz.

Perfil. Guillermo Simari es Profesor Emérito de la Universidad Nacional del Sur (UNS). Doctor of Science (Ph.D.) por la Washington University. Licenciado en Matemática por UNS. Es fundador en 1992 del Grupo de Investigación en Inteligencia Artificial (GIIA) y desde el año 2000 del Laboratorio de Investigación y Desarrollo en Inteligencia Artificial. Fue decano del Departamento de Ciencias e Ingeniería de la Computación de la UNS y ha publicado sus trabajos en revistas científicas y editoriales de todo el mundo.

***

Cuando Friedrich Nietzsche utilizó la expresión “demasiado humano” definitivamente no estaba pensando en un cyborg (organismo cibernético) o en la idea de prótesis maquínica. De todos modos aportó una serie de preguntas que siguieron abriendo la herida narcisista de la humanidad, tal como lo hizo Darwin o Freud. La herida no sanó jamás y ahora surge la pregunta muy a pesar de Nietzsche, ¿si no hubiera más humano y éste ya fuera otra cosa?

Aparecen así los debates sobre posthumanismo y transhumanismo, la hibridación hombre-máquina y la expansión de las facultades sensoriales, ya no sólo por los dispositivos, sino también por la potencialidad de la inteligencia artificial (IA). Y frente a un escenario de posible evolución de la especie aparecen también las preguntas éticas.

“Hoy en día hablar de dispositivos electrónicos y no hablar de inteligencia artificial es dejar la mayor parte del desarrollo afuera. No hay una posibilidad de separar la IA de la informática. De hecho es la parte más novedosa y más efectiva de la informática”, afirma el docente.

“si uno lograra desarrollar lo que se llama ‘inteligencia artificial general’, ¿qué pasa con ese dispositivo?, ¿qué derechos tenemos nosotros sobre ese ‘individuo’ que hemos creado y que es ‘casi como’ un ser humano?”

Hace unos setenta años, después de culminada la Segunda Guerra Mundial, el matemático Alan Turing había propuesto un simple test que imaginaba un desafío: si un humano tenía un diálogo con una máquina que se hiciera pasar por una persona, y el humano no podía determinar después de la charla si había hablado con un humano o una máquina, entonces se habría alcanzado un umbral de inteligencia artificial. El test se popularizó y es un hito en la historia de la informática, pero desde ahí hasta ahora, ¿no ha habido una sobrevaloración de la posibilidad de la inteligencia maquínica?

“Sucede que hay áreas calientes dentro de la IA -define Simari-, que reciben atención mayor en momentos determinados. En la actualidad hablamos de machine learning (aprendizaje de máquina). Eso está fogoneado porque hay grandes masas de datos que están disponibles y se pueden utilizar para aprender. Hay mucho dinero en esto, en la utilización de los datos que dispone una compañía. Así las empresas pueden planear sus desarrollos en función de los requerimientos que se aprenden de los datos que los clientes ya tienen”. Es decir que más allá de los imaginarios colectivos sobre las máquinas que piensan, hay una zona de la economía que se mueve, y mucho, gracias a estos desarrollos.

Aunque todo esto no tenga tanto que ver con lo planteado por los pioneros como Turing, son esas chispas las que permitieron avanzar en técnicas como el big data. ¿O no?: “Creo que han cambiado las metas. Lo que ha sucedido es que hay sistemas que tienen mayor impacto porque han aparecido las masas de datos que se pueden utilizar para aprender”.

“Las técnicas de machine learning que se están utilizando hoy ya son bastante viejas, es decir que en términos de investigación han sido desarrolladas en los últimos veinte años y hoy en día se implementan porque aparecieron los datos, que antes no estaban. Recién hoy se puede aprovechar esa técnica. De hecho su creador, Geoffrey Hinton, dice que hay que tirar todo y empezar de nuevo”, apunta Simari.

“El problema es que la tecnología afecta nuestra vida de una forma tan profunda que… es imposible pensarse por fuera de ella, incluso para los grupos religiosos que intentan mantenerse como en el siglo XIX”

Los desarrollos tecnológicos pueden ser vistos desde muchos puntos de vista. Desde la condena luddita (movimiento de los destructores de máquinas de los comienzos de la Revolución Industrial) hasta el reduccionismo matemático de la ley de Moore (que dice que cada dos años se duplica la potencia informática), o el optimismo sin más de Marshall McLuhan, de pensar el mundo como un gran sistema nervioso interconectado. Incluso hay corrientes filosóficas como el aceleracionismo que parten de Gilles Deleuze y Tony Negri para hacer una crítica al capitalismo desde el análisis de la relación tecnología-sociedad.

En este sentido Simari propone pensar “todos” los componentes del desarrollo tecnológico, no solo “el componente intelectual humano y su curiosidad”. “La parte comercial” sigue estando ahí como factor determinante: “Descubrimientos disruptivos como internet, que no se pensaron desde lo comercial, con el tiempo lo fueron incorporando y así empezó a tener un control bastante fuerte sobre lo que se puede y no se puede hacer, principalmente porque se termina buscando siempre el retorno de la inversión. Los investigadores, al recibir el apoyo de un gobierno o de privados, ya tienen condicionados sus desarrollos”.

Debates, ética y razones prácticas

-En su opinión, ¿qué tipo de debates se inauguran con el desarrollo de la inteligencia artificial?

-El desarrollo de la inteligencia artificial y su parte ética es algo muy complejo. Por ejemplo se trata de pensar qué pasa al asignar ‘responsabilidad’ a un sistema, sea este sistema de armas autónomas, mediante un automóvil que se maneja automáticamente, o en un diagnosticador de enfermedades. Y también preguntas que pueden ir más allá: si uno lograra desarrollar lo que se llama ‘inteligencia artificial general’, ¿qué pasa con ese dispositivo?, ¿qué derechos tenemos nosotros sobre ese ‘individuo’ que hemos creado y que es ‘casi como’ un ser humano? Es decir, si tiene la inteligencia de un ser humano y tiene conciencia de sí mismo ¿hay un problema serio en lo ético? Por suerte estamos bastante lejos de este último problema.

-Uno de los ejemplos que dio es muy poco debatido: armas autónomas. ¿Cómo lo puede definir?

-Es cualquier dispositivo que puede provocar daño y que pueda tomar la decisión de provocar daño sin necesidad de que intervenga un ser humano. Se están desarrollando a pesar de que hay un convencimiento de la población, e incluso de los investigadores, de que no debería hacerse. Y sin embargo se hace.

–En relación a la tecnología, y a la ciencia en general, es muy difícil encontrar un espacio para desarrollar teoría crítica. En relación a la tecnología aparecen rápidamente las acusaciones cruzadas de medievalismo, luddismo, positivismo, etcétera. Tal vez el único reducto haya sido el iniciado por Richard Stallman desde el movimiento del software libre, una expresión crítica hecha desde dentro. ¿Cómo se siente usted en relación a la crítica?

-El problema es que la tecnología afecta nuestra vida de una forma tan profunda que… es imposible pensarse por fuera de ella, incluso para los grupos religiosos que intentan mantenerse como en el siglo XIX. Entonces lo que sí hay es mucha gente preocupada por el desarrollo tecnológico, gente que está pensando en cómo lograr que tenga un buen sentido y dirección. Uno de los avances, por ejemplo, es el que tuvo la Comunidad Europea al aprobar una legislación que obliga a que los sistemas de IA expliquen por qué toman las decisiones que toman o que recomiendan tomar. Esto representa un condicionamiento a los sistemas basados en machine learning dado que actualmente no tienen la capacidad de explicar sus decisiones, y a la vez presenta un desafío para que se investigue cómo producir esas explicaciones en esos sistemas. Y esto es un avance significativo. En Naciones Unidas, por ejemplo, hay un grupo que está trabajando en IA con 17 metas que ellos llaman “metas sostenibles” en las que buscan cómo aplicar las tecnologías de inteligencia artificial a 17 áreas destacadas, como la producción de alimentos o el agua limpia. Pero en términos generales la situación es que desde muchas áreas se está percibiendo cómo el impacto de la tecnología directamente cambia nuestra forma de comportarnos. Creo que ha habido un gran avance en términos amplios, porque se pueden analizar los problemas y encontrar soluciones a los usos de la tecnología, sobre todo porque hay un desarrollo rápido y hay que acostumbrarse rápidamente a los usos.

Nota:

(1) Congreso de desarrolladores que organiza Google todos los años desde el 2008. Allí se presentan y debaten, principalmente, el futuro de los productos de Google. La Electronic Entertainment Expo, Expo 3, o simplemente “E3”, es la convención de videojuegos más importante de la industria gamer del mundo.