Que el fuego no tape el bosque

Por Marcelo Maggio

Cada verano se inicia esa secuencia de noticias destinada al lamento y la indignación. Se nos cuenta la cantidad de hectáreas perdidas en cada incendio y en cada provincia. Se confunde un incendio con el siguiente y en algunos casos aparece la solidaridad y en otros la indiferencia. ¿Qué pasa con el bosque luego del fuego? ¿Podremos proteger los árboles, los bosques nativos y los ecosistemas?

Según los datos que reportó la Dirección Nacional de Manejo del Fuego, fueron afectadas por el fuego unas 300 mil hectáreas de bosque en todo el país en el año 2024. Y la cantidad de focos de incendio que se generan es cada vez mayor. Si bien las provincias de Córdoba y San Luis fueron las más perjudicadas en términos de superficie, los incendios padecidos por localidades como El Bolsón o en el Parque Nacional Lanín (ambos en la Patagonia), sin duda, fueron los que más alarma generaron, por su impacto social (700 familias evacuadas sólo en la localidad rionegrina) o por el valor ambiental puesto en riesgo (casi 20 mil hectáreas de destrucción total en el parque de la provincia de Neuquén).

Las causas múltiples y el manejo del fuego

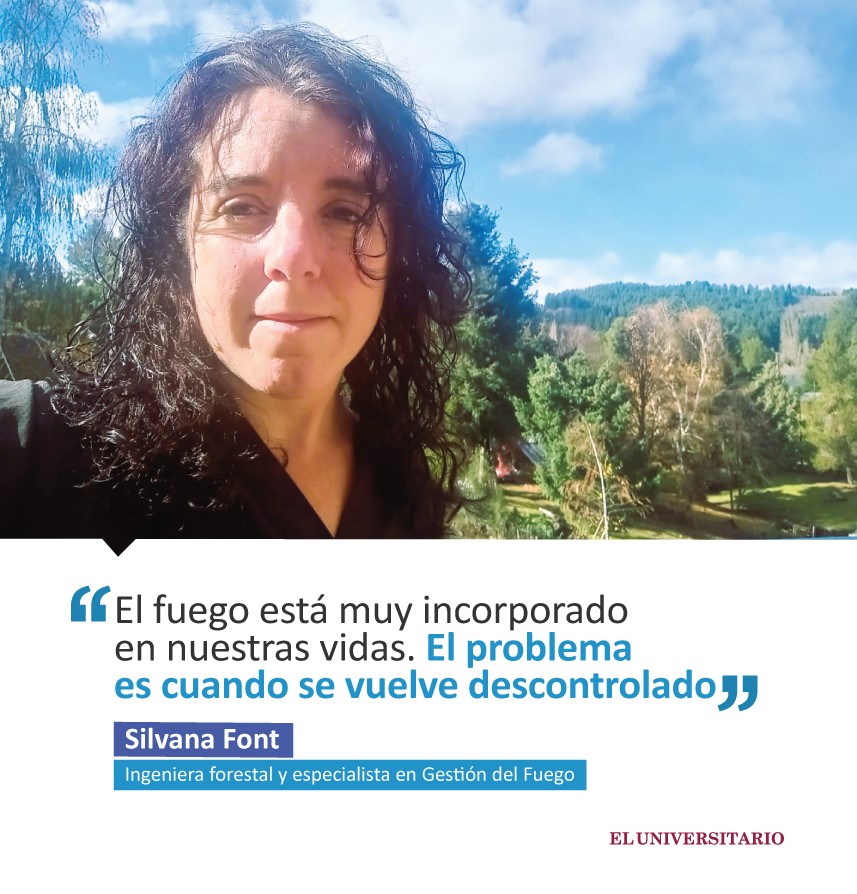

Las causas de los incendios son múltiples: negligencia, uso inadecuado del fuego, urbanización sin planificación y efectos del cambio climático. Silvana Font, especialista en Gestión del Fuego e ingeniera forestal, residente en la localidad de San Martín de los Andes (Neuquén), señala: “El fuego está muy incorporado en nuestras vidas. El problema es cuando ese uso no es responsable y se da una convergencia de factores como material combustible, una chispa y condiciones climáticas propicias”. Tan incorporado que nos parece natural su presencia favorable: calefacción, cocción, hasta manejo de pastizales. “El tema es que esté bien usado. No podemos decir 'no fuego'. Esas campañas nos meten en problemas, porque el lema debe ser 'no incendio, no al fuego descontrolado'. Poder saber lo que hacemos cuando utilizamos el fuego”.

Para Font, la respuesta debe ser fomentar el compromiso local: “Estamos intentando pensar en un manejo integral del bosque. Cuando lo planificás, que no sea sólo para sacar madera, sino para ver el ordenamiento del recurso: está probado que es necesaria la participación social para generar un compromiso con las medidas que se vayan a tomar”. Trabajar a nivel municipio, barrial, en escalas pequeñas y ver lo que sucede en cada lugar. “Lo tiene que tomar la gente, porque hay mucho de autoprotección en esto, conocer los cuidados que hay que tener”.

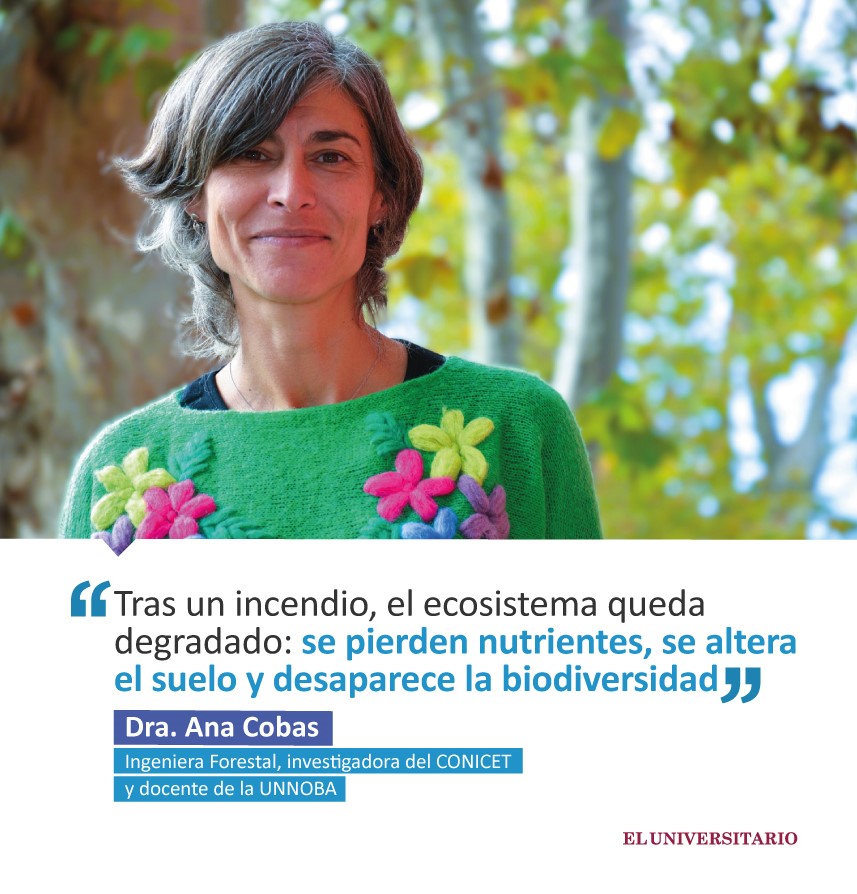

Desde un punto de vista ecológico, Ana Cobas, ingeniera forestal, docente de la UNNOBA e investigadora del CONICET, comenta que hay especies adaptadas al fuego en sus ambientes naturales. Sin embargo, aclara: "Hoy vemos incendios en zonas donde las especies no están preparadas para resistir. Allí, el cambio climático aumenta las temperaturas y disminuye la humedad y el ecosistema no puede regenerarse sin intervención humana”.

Por otra parte, desde un punto social, es necesaria la planificación urbanística para evitar riesgos en la vida de las comunidades: "Si vas a planificar un pueblo o una ciudad en un medio agreste deberías preparar una cortina cortafuego", afirma Cobas. La idea del "cortafuegos" es simple, pero requiere mantenimiento, planificación, o ambas cosas a la vez: se trata de generar una barrera entre zonas con riesgo inflamable para impedir la propagación. Pueden ser barreras naturales, como una zona de piedras o de agua; artificiales, como un camino despejado de toda vegetación; o también verdes, aprovechando plantas y árboles muy resistentes al fuego, entre otras estrategias posibles.

El día después: suelo degradado y ecosistemas en crisis

El impacto del fuego va más allá de la vegetación quemada. “Después del incendio, te encontrás con un ecosistema que perdió sus nutrientes, suelos erosionados y aire contaminado por partículas suspendidas”, explica Cobas. Además, muchas especies animales no logran escapar y mueren, o pierden su hábitat, generando una ruptura en el equilibrio ecológico.

La recuperación es posible, pero requiere estrategias claras. “Donde se pueda, hay que favorecer la restauración pasiva, sin intervenir. En otras zonas, es necesario proteger el área, evitar el ingreso de personas o animales, y monitorear la regeneración”, plantea Font, y brinda como ejemplo lo implementado en el caso del Valle Magdalena ubicado en el Parque Nacional Lanín.

Sin embargo, el fuego puede ser pensado como parte de determinados ambientes, "ecosistemas donde los incendios son frecuentes y las especies están adaptadas, porque es su ambiente natural, lugares donde cada cierto tiempo hay un incendio, lugares desérticos o de alta temperatura”, revela Cobas. Sin embargo, “lo que nos estamos encontrando ahora son incendios, que pueden ser intencionales o no, donde hay especies y ecosistemas que no están preparados para que ocurran esos eventos”.

—¿Se trata del cambio climático?

—Sí. Hay zonas donde empezamos a tener más temperatura y menos humedad, como pasa en la Patagonia. Entonces nos encontramos con especies arbóreas que no están preparadas para resistir, para tener una estrategia que contenga la propagación o para salir de rebrote y volver a fortalecerse luego del incendio. Son especies que no pueden volver naturalmente al punto original y que necesitan una ayuda humana.

—¿Cómo es "el día después" del incendio forestal?

—"El día después" del fuego te vas a encontrar con un ecosistema con materia orgánica eliminada y degradada. Y vas a perder árboles por la pérdida del soporte de la estructura del suelo. Entonces, habrá erosión. Además, habrá cambios en la temperatura del suelo, porque no se apaga y vuelve rápido a la temperatura que tenía antes. Va a seguir siendo un ambiente cálido. Además, está el impacto en el aire, porque se liberan una cantidad de partículas que llegan hasta cientos de kilómetros. Entonces, primero hay que esperar a que ese ecosistema vuelva a sus condiciones ambientales: que baje la temperatura, que tenga corriente de oxígeno y observar qué es lo que quedó. ¿Hay árboles en pie? ¿Qué condiciones tienen? El suelo, ¿cómo quedó? ¿Podemos intervenir con pasturas de la zona para favorecer la recuperación?

Entre la conservación y el uso productivo

Ambas especialistas coinciden en que los incendios también abren el debate sobre el uso del suelo. Mientras algunos sectores promueven convertir zonas afectadas en áreas productivas, las voces técnicas alertan sobre los riesgos de introducir especies exóticas inflamables, como el pino, que no sólo alteran la biodiversidad sino que agravan el riesgo de incendios futuros.

“La prioridad debe ser conservar el bosque nativo y evitar que las especies invasoras ocupen ese nicho. No es sólo reforestar: se trata de recuperar la complejidad del ecosistema”, indica Cobas. Por su parte, Font subraya en relación a los parques y reservas, que “hay que evaluar en cada lugar qué hay que hacer, si cerrar o no. Cuando cerrás, lo mejor es que no se saque madera, que no entren animales, que no haya gente circulando, que no se pise el suelo para poder favorecer la restauración natural, la restauración pasiva”. Pero no es tan fácil donde existe gente viviendo en el bosque, porque “hay muchas más causas posibles y más combustible también. También aparece la amenaza real sobre la vida de la gente. Son problemáticas con mucha prensa cuando se está en plena crisis, pero que tendríamos que trabajar todo el año desde la prevención”.

Por otro lado, existe un manejo específico para el sector productivo de las plantaciones. Font indica que “una plantación sin gestión, es un riesgo; no es lo mismo que una forestación planificada con cortafuegos y manejo del combustible”.

Si bien las plantaciones están preparadas y planificadas con caminos cortafuego, requieren de un trabajo y vigilancia permanente de limpieza y desmalezamiento, para mantener libres y despejados los sectores clave en el caso de que ocurra un incendio. De todos modos, las especialistas aclaran que no se debe confundir una plantación de una sola especie con un bosque, ya que la biodiversidad de este último es algo totalmente diferente.

Para las plantaciones, y desde el punto de vista del “manejo del fuego”, lo que afecta es lo que no está gestionado, “como fue el caso de la localidad de Epuyén (Chubut), que tuvo plantaciones abandonadas, sin gestión, intercaladas entre la población”, recuerda Font. “Una plantación gestionada tiene un cuidado del entorno, pero una plantación abandonada es un riesgo por todo el material combustible que va quedando”, subraya. Además está el problema ecológico en ese abandono, porque esas especies no nativas resultan muy inflamables, como sucede con el pino: "Las especies exóticas pueden generar un incendio con un comportamiento muy virulento. En cambio, para las especies nativas el fuego puede formar parte de la dinámica del bosque”.

La doctora Ana Cobas agrega: “Hay árboles que están en ecosistemas en los que los incendios son frecuentes, por alta temperatura o falta de humedad. En esos casos los incendios se dan de manera natural y, por eso, la especie ya está preparada, por ejemplo con la resistencia de su corteza a la temperatura o el fuego”.

¿Y las políticas públicas?

“El bosque nativo viene siendo degradado y eliminado, de a poco —indica Cobas—. No es algo de este momento específico o del fuego. Se viene degradando desde hace décadas, por el cambio de uso del suelo. Se ha ido sacando bosque nativo para hacer plantaciones o ciudades durante décadas. Todo eso generó una modificación ambiental”.

Pese a que Argentina cuenta con la Ley de Bosques y la Ley de Manejo del Fuego, la falta de financiamiento y la centralización de decisiones limitan su impacto. Font advierte que “la prevención solo funciona si se articula a nivel local. En lugares como Merlo (San Luis), se han logrado acciones coordinadas entre bomberos, universidades y municipios que permiten una mejor gestión”.

Ambas expertas coinciden en que la universidad tiene un rol clave. “Es fundamental generar participación social. La gente tiene que apropiarse de la información para prevenir y también exigir planificación. No podemos pensar solo en el combate al fuego, sino en toda la gestión del recurso”, resume Font.

Menos Estado, más descontrol

En relación al ordenamiento legal que puede impactar para prevenir y detener los incendios forestales, se pueden destacar al menos tres leyes. En primer lugar, la Ley 26.737 (año 2011) con el título de “Régimen de Protección al Dominio Nacional sobre la Propiedad, Posesión o Tenencia de las Tierras Rurales”, conocida como "Ley de tierras". Esa ley consideraba la tierra como soberanía nacional bajo el argumento de ser un recurso no renovable, limitando para ello la posesión, explotación y titularidad para las personas extranjeras. La ley fue derogada por el decreto 70/23, conocido públicamente como “mega DNU”, emitido por Javier Milei apenas asumir su presidencia. En este sentido, fueron los vecinos de la localidad de El Bolsón quienes se expresaron categóricamente y quienes, luego de ser afectados por incendios, establecieron que el abandono de esta ley tenía directa relación con sus problemas. Este cambio legal, por ejemplo, habilita que grandes extensiones del territorio (sean limítrofes con otros países o contengan espejos de agua) puedan ser puestos a la venta a cualquier tipo de capital extranjero, poniendo en riesgo la integridad del territorio y su manejo responsable.

La segunda herramienta era la Ley 26.815 del “Sistema Federal de Manejo del Fuego” (año 2012). Esta ley establecía que la autoridad de aplicación para el manejo nacional de prevención de los incendios debía ser la Secretaría de Ambiente y Desarrollo Sustentable de la Nación. Sin embargo, en marzo de este año, el gobierno de Javier Milei traspasó la autoridad a la órbita del Ministerio de Seguridad. “Tenemos una Ley de Manejo del Fuego que quedó completamente congelada con la llegada de este Gobierno”, denuncian desde sectores ambientalistas. Según los datos de la Oficina de Presupuesto Nacional, del Ministerio de Economía, el presupuesto 2024 destinado al Sistema Federal de Manejo del Fuego fue subejecutado, hasta el punto que durante el primer trimestre del año pasado, estuvo paralizado, es decir con cero pesos.

En tercer lugar, está la Ley 26.331 de “Presupuestos Mínimos de Protección Ambiental de los Bosques Nativos” (votada en el 2007), que tiene el objetivo de combatir la deforestación. Esta ley fue desarticulada al desarmarse su fideicomiso, esto es, el modo de acceder a los fondos y el financiamiento que pueden obtener las provincias que sufren esta problemática. Fueron casi 15 mil millones de pesos los que se recortaron y que estaban destinados a la protección de los bosques.

¿Cómo involucrarse en el problema desde nuestra región?

Aunque Junín o Pergamino no estén en zonas de riesgo extremo, el cuidado del arbolado urbano también forma parte de esta problemática. “Hoy hablamos de bosques urbanos, no solo de arbolado. Se trata de pensar qué servicio ecosistémico brinda cada árbol, su calidad, su espacio, su planificación”, señala Cobas, doctora en Ciencias Agrarias y Forestales. El bosque urbano llega como categoría que nos interpela de otra manera.

La concientización, la planificación de especies, el mantenimiento responsable, el uso de residuos vegetales para compostaje o leña, son algunas de las acciones posibles en el ámbito local. Y, sobre todo, el rol de la universidad pública como espacio de formación, investigación y acción concreta frente a los desafíos ambientales del presente, que implican no solo tomar conciencia sino también participación ciudadana.

Diseño: Laura Caturla

Fotos de portada externa e interna: Leonardo Ariel Casanova

Diseñar en un ambiente universitario

Por Marcelo Maggio

En la última Feria del Libro que se realizó en Junín una familia visitó el stand de la UNNOBA. Mientras el pequeño hijo se sentaba en el suelo para mirar los dibujos de Indiecito dormido, la madre mantenía la mirada atenta y aprovechaba para ojear Presente. Relatos de ex combatientes. Le gustaba la portada. Nada de esto vio el padre, que recorría con la cara pegada a las hojas, casi oliendo, cada una de las revistas científicas exhibidas. Le mostró un artículo al encargado del lugar y le preguntó algo. Cuando se fueron, habían comprado sólo un ejemplar, el que había pedido el hijo, pero dejaron la promesa de volver, más tranquilos, para mirar bien eso que ahí tenían y que no estaba en ningún otro lugar de la feria.

Esa escena, ese momento, abrió la inquietud por entrevistar al Centro de Edición y Diseño de la UNNOBA, que entre sus tareas tiene la de publicar esos libros y revistas y, también, la de tomar contacto con un público general en una feria. Un diálogo que pueda partir de esa experiencia editorial para preguntarnos por las incursiones, cada vez más exigentes, como las del mundo digital. Del libro en papel al libro electrónico, de la publicidad en un diario blanco y negro a una animación para Instagram, de pensar la identidad gráfica de una institución a la gigantografía de un edificio. Cambia la interfaz, ¿cómo se piensa desde el diseño?

Un camino de veinte años

El Centro de Edición y Diseño de la UNNOBA (CEDI) fue creado en 2005. Desde aquel año, María de las Mercedes Filpe es quien dirige el espacio. Ella recuerda que entre las primeras necesidades de la Universidad estaba la de “generar identidad y un posicionamiento en el territorio, darse a conocer en la comunidad”. Para lograrlo, hicieron un desarrollo de marca “en una época en la que todavía se usaba mucho el papel y la imprenta”.

La UNNOBA llevaba casi tres años de vida y la necesidad de comunicar con una identidad visual se imponía como un requisito. “Hicimos varios cambios en el desarrollo de marca hasta llegar a la actual —rememora Filpe—. En aquella época aún no teníamos la tarea de edición como una demanda presente, pero de todos modos lo incorporamos en el nombre de nuestra área, porque era algo que sabíamos que iba a venir con el tiempo”. Una universidad que recién nacía no tenía una masa crítica de material para publicar, pero luego de los primeros años apareció esa demanda.

Cristian Rava es coordinador del CEDI y docente de Diseño en la UNNOBA. Respecto las tareas de edición, destaca: “Con el CEDI integramos desde el año 2012 la Red de Editoriales Universitarias (REUN), donde participan todas las universidades que tienen editorial”. En el marco de esta red, la UNNOBA fue seleccionada para colaborar en diversos proyectos. Rava destaca la asignación al CEDI para la tarea de la Colección Malvinas Argentinas: “Se trataba de producir el diseño de una colección completa, un material luego publicado por UNLP, UBA, UNC, entre otras. Como la REUN es una red colaborativa, nuestra tarea estuvo centrada en el diseño; éramos la única editorial con la totalidad de diseñadores en el equipo”.

El libro

—Este año se realizó la Feria del Libro número veinte en Junín. Pergamino relanzó la feria en un nuevo espacio. En todos los casos el CEDI tuvo participación. Incluso los libros de la UNNOBA están presentes en los stands de todo el país gracias a la REUN. ¿Qué pasa cuando el público general toma contacto con una editorial universitaria?

Mercedes Filpe—Tratamos de tener una participación activa para todas las escalas de feria, sean la feria de Buenos Aires, Pergamino o Junín. Es importante estar en las ferias porque muchas veces va un público que no va a librerías, van las familias, y el libro puede hacer otro recorrido. La Feria del Libro de Buenos Aires es una de las más importantes de la región, por la que pasan miles de personas por día, con público escolar y general, y ahí hemos presentado muchos de nuestros libros y hasta nuestras revistas académicas. Lo primero que advertís en un espacio así son las ventas, porque libros como Indiecito dormido (Atahualpa Yupanqui, 2017) o Presente. Relatos de excombatientes (2012) se mueven y uno se pregunta los motivos. Pero eso creo que pasa con todos los libros, como si siempre estuviera esa media naranja que falta, ese destinatario objetivo para cada título.

Cristian Rava—La importancia de tener un stand en una feria también implica la visibilidad. Hay gente que puede conocer EUDEBA (la editorial de la Universidad de Buenos Aires), pero quizás desconocen que la UNNOBA tiene una editorial. Otros, en cambio, quienes ya nos conocen, pasan y preguntan “¿qué tienen ahora?”, o nos piden libros de otras editoriales universitarias. Creo que año tras año damos un pasito más hacia adelante en posicionar la editorial universitaria.

—¿Cómo se piensa el contenido a publicar para la editorial, lo que se denomina la curaduría? ¿Hay convocatorias, concursos, pedidos de áreas de la universidad, iniciativas propias?

MF—Fuimos cambiando la dinámica a lo largo del tiempo. Al principio teníamos que salir a buscar a alguien que se anime a publicar. Buscamos dar un impulso con la revista Núcleos para abrir el campo a los investigadores, una revista abierta a todas las áreas que generó un panorama interesante. Después decidimos lanzar convocatorias, hasta llegar a la actualidad en que nos encontramos superados en la demanda, de modo que no estamos publicando todas propuestas que nos llegan. En parte nos estamos acotando a partir de la crisis de recursos que tiene la universidad. Hay costos de producción que van más allá de si un producto es digital o en papel. El recurso humano siempre tiene que estar y eso hay que tenerlo presente.

¿Un texto analógico y otro digital?

—¿Cómo piensan el diseño de textos en una cultura que se va reconvirtiendo cada vez más al consumo de lo visual a partir de la digitalización? ¿Es necesario pensar los textos y la comunicación de otra manera?

MF—Nuestra formación disciplinar hace que pensemos a los textos como imagen, siempre fue así. Después esa imagen, que es un texto, puede ser estática, dinámica, tener distintos contrastes, jugar con ilustraciones o con cuadros. Pero siempre el bloque de texto es una imagen. El texto es comunicación más allá del signo letra. Para nosotros la letra es una forma que cumple una función dentro de un texto, pero también es una imagen. Esa imagen, depende del campo en el que juegue, se trabaja de una manera o de otra.

CR—Está el ejemplo de la revista Núcleos. Estamos acostumbrados a ver revistas de divulgación científica muy básicas en cuanto al diseño. Cuando llevamos el primer número de Núcleos a una reunión con otras universidades nos preguntaban si era una revista científica. Creemos que esta revista tiene un plus, que es el diseño.

Más allá del usuario y sus demandas

—¿Se encuentran con otras demandas sobre el diseño, nuevas exigencias? Tal vez el nuevo escenario de usuarios cada vez más participativos y que producen contenidos para las redes sociales genera nuevas miradas o sensibilidades.

MF—Ezio Manzini, que es el autor más prestigioso que tenemos en este momento a nivel internacional, publicó un libro titulado Cuando todos diseñan (2019). Ya el nombre lo dice: hoy cualquier persona genera contenido para su red social y para eso tuvo que saber qué imagen elegir, cómo la utiliza, experimentar; pero ese usuario sigue siendo un explorador. Está bien que convivan las publicaciones domésticas con las profesionales en las redes, es como cuando alguien va a un taller de plástica y pinta, ¿eso te convierte en Picasso? No, pero está muy bien. Entonces aunque cambien los escenarios y los soportes, sigue sin cambiar lo sustancial. Cuando todos diseñan es eso, todos pueden escribir poesía también, es algo que fluye. Es más, es interesante que un usuario de redes pueda desarrollar su sensibilidad, su estética, encontrar lo que le gusta, es como una nueva puerta que se está abriendo.

CR—Las redes sociales como Instagram mejoraron mucho a sus usuarios en relación a la calidad de imágenes a utilizar. Ese es un aspecto. Por otro lado, los encasilló y todos empezaron a publicar lo mismo, con el mismo patrón. Que todos se acostumbren a hacer lo mismo es un problema, se copia un modelo y falta lo disruptivo. Creo que en esa labor estamos los que venimos del diseño. Y en el caso de Canva o las plataformas de inteligencia artificial también se maneja lo estandarizado, ¿dónde está el contexto? No lo hay, es un vacío, pura repetición de patrones.

—Sin embargo, incluso teniendo en cuenta estos problemas, ¿no podemos pensar que estos usuarios podrían ser más exigentes?

MF—Claro, se va desarrollado una sensibilidad estética que puede ver sobre todo en el armado y en las producciones que estos usuarios hacen visibles. Por eso la nuestra es una profesión en la que todos opinan, todos saben y son “expertos”, pero esos condicionamientos desde la demanda siempre los tuvimos.

—¿Cómo resuelven la convivencia de las nuevas demandas digitales con las tradicionales, denominadas "analógicas" o materiales?

MF—Nosotros siempre partimos de defender la idea de sistema, la unidad en la diferencia. Para nosotros es lo mismo tener que amalgamar diferentes colecciones de libros, una señalética de un edificio o publicaciones para una red social. Partimos del concepto de la sistematicidad orgánica de una marca, que después se va ampliando a una base enorme de un sistema marcario que funciona tanto en digital como en analógico. Por supuesto que hay demandas particularmente analógicas, como una gigantografía para un edificio, donde juegan otras variables que no aparecen en un posteo, como el volumen, el peso, las sombras, el sol. Pero desde el diseño todo esto convive siempre: hay que saber generar algo analógico a veinte metros de altura contemplando la separación con la pared y la seguridad personal, hasta una tarjeta de fin de año que circula por WhatsApp.

Libro electrónico

—Ustedes están incorporando cada vez más publicaciones digitales en formato de libro electrónico. ¿Cómo se define un libro electrónico?

CR—La primer respuesta sería por la negativa: no es un PDF. Cuando vos mandás a imprimir un libro mandás un archivo PDF, sí, pero ese archivo tiene una cantidad de características para que la imprenta lo pueda transformar en un formato analógico. Si vos publicás en digital cambian esas características, aunque el soporte pueda ser el mismo. En digital hay variables como el reconocimiento de las tipografías, la compatibilidad con los dispositivos, la luminosidad del fondo respecto del texto. Por ejemplo, están quienes prefieren leer desde una pantalla de computadora, también quienes eligen dispositivos específicos, como el ebook-reader, o quienes leen con pantalla negra y tipografía blanca, o quienes leen online. Por lo tanto, el mundo del diseño digital tiene cada vez más aristas que evaluar y nuestro desafío es pasar ese documento de texto que nos llega, ese original, hacia algo digital que se siga viendo como si fuera papel, con la posibilidad del descanso entre líneas, con espacios blancos, con un manejo de la imagen. El desafío de lo digital es que al correrse los límites hay que pensar muy bien todas esas características.

MF—Creo que podemos volver al inicio de la charla: para nosotros el texto es imagen. Entonces es imagen tanto en papel como en digital. Hay características en la terminación física de los libros que hacen que el libro comunique y se convierta en un objeto de comunicación. En lo digital pasa lo mismo, también es un objeto de comunicación: no es que por ser algo virtual ya no comunica. Por lo tanto hay que cuidar todos sus elementos y características en el diseño.

—¿Qué pasa con la información que ya no está por ese pasaje del objeto físico al digital? Por ejemplo en un libro todo lo que transmite una tapa, la contratapa, el volumen del objeto.

MF—No es pérdida, es transformación.

CR—Quienes mantienen una experiencia de lectura saben que determinadas características pueden traer limitaciones. El papel blanco cansa la vista, lo sabemos. Un fondo blanco en la pantalla, también cansa. Entonces, ¿qué podemos hacer? Bueno, hay que darle otra tonalidad al fondo, como emular el papel, o bajar el tono negro de la tipografía para disminuir el contraste. Hay una gran cantidad de posibilidades que se ofrecen, aunque no siempre se pueda explorar todo a fondo, porque también existen tiempos de entrega marcados por la dinámica de trabajo.

Publicar la ciencia en la web

—Ustedes mencionaban Núcleos. En relación a las revistas, resulta interesante cómo está cambiando el concepto de los tiempos de recepción y publicación, por ejemplo mediante una metodología abierta durante todo el año, algo que ha llegado gracias a la web.

CR—Hay una plataforma que implementó el Conicet que es la que nos permite eso a las universidades. Se llama Open Journal Systems (OJS). No podemos publicar la revista en un sitio web cualquiera, tiene que ser utilizando este sistema, muy complejo y que contempla todas las instancias, desde autoría y revisión hasta corrección y publicación. Cada uno que ingresa, carga y realiza sus tareas, y todo el proceso se puede resolver en menos de un mes. Todos pueden trabajar dentro de la misma plataforma, se puede avanzar y resolver toda la publicación de un modo eficaz. ¿Qué es lo que no se contempla? La parte de diseño. Por eso tuvimos una charla con la gente del Conicet para mejorar la plataforma en este sentido, porque el diseño no está.

Diseñar en tiempos de crisis

—¿Qué desafíos tiene el CEDI de cara al futuro?

MF—Somos un área especial, porque trabajamos mucho por los pedidos que nos hacen y en ese sentido el margen de decisión es limitado. A la vez sabemos que somos una herramienta que le da visibilidad a la Universidad. Nos gustaría que, en función de esa importancia que cobra el trabajo una vez realizado, podamos contar con un crecimiento acorde. Hemos logrado avanzar en el posicionamiento de marca, en la implementación de un sistema, y luego pasarlo a las redes. Nos está faltando poder dedicarle todos los recursos necesarios al área editorial.

CR—Esperamos siempre los tiempos institucionales para dar los pasos; por ejemplo nos ha pasado de presentar proyectos sobre los que nos dijeron que sí pero que no era el momento. Eso hay que entenderlo, no tenemos que tener la ansiedad de querer hacer todo cuando surge la idea y comprender los tiempos de la Universidad.

Juicio por jurados: el ámbito de litigio más exigente

Por Marcelo Maggio

Los juicios por jurados son desde siempre uno de los temas favoritos del cine y de los públicos. Escenas, debates y conflictos que se nos muestran en la distancia de la ficción. Sin embargo, ¿tienen algo que ver con la realidad que vivimos como ciudadanos? ¿Qué tanto se implementan? Y los profesionales que intervienen, ¿serán como ese protagonista de la serie que tanto nos gustó?

Lejos de las pantallas, el ejercicio de la oratoria aparece hoy como una destreza que estudiantes de derecho de todo el país preparan, no sólo para enfrentarse en un concurso nacional sino, fundamentalmente, para su futuro ejercicio profesional.

Desde el Seminario de Litigación Oral que se dicta en la carrera de Abogacía de la UNNOBA se organizan y capacitan equipos de estudiantes que participan todos los años en este concurso. Uno de los responsables del seminario es Pablo Santamarina, docente y fiscal provincial, quien destaca el aspecto formativo que tienen estos concursos, “porque el litigio se aprende litigando”. Este año el desafío es doble para la UNNOBA, porque además de aportar su equipo para competir, también será la universidad sede, en la ciudad de Pergamino.

“Uno de los puntos más fuertes del concurso es la participación en sí —indica Santamarina—, porque no sólo importa ganar o ver cómo litigan los otros, sino que hay una instancia social muy fuerte, y que resulta difícil de apreciar en toda su dimensión por todo lo que aporta al aprendizaje de los estudiantes”.

El Concurso Nacional Universitario de Litigación Penal es una competencia en la que participan universidades públicas y privadas de todo el país y de la región. Más de treinta universidades y cuatrocientas personas entre estudiantes y docentes estarán una semana en la UNNOBA para la etapa presencial del evento, a desarrollarse del 4 al 8 de noviembre.

El docente destaca que “desde la creación del seminario, en 2015, nunca se dejó de participar”. Y elogia los resultados: “Los estudiantes serán mejores litigantes que nosotros, porque inmediatamente adquieren la lógica y las herramientas”. Aunque también hay dificultades a resolver. Señala que todo lo relacionado con la lectura, esos “problemas que se arrastran de los niveles de formación anterior y que no les ayuda al momento de comunicar”.

En relación a la organización del concurso, la idea nació del Instituto de Estudios Comparados en Ciencias Penales y Sociales (INECIP) para hacer un concurso nacional en distintas sedes. La UNNOBA repetirá este año como anfitriona (la anterior experiencia en nuestra Universidad había sido en 2016, en la sede Junín), ya que “estaba previsto hacerlo en Salta y por las dificultades económicas del traslado se buscó una zona central del país”.

El seminario

El seminario de Litigación Oral nace en 2015 como un espacio de formación optativa. Pero rápidamente se toman en cuenta las indicaciones del Ministerio de Educación de la Nación y pasa a ser obligatorio para todos los estudiantes de abogacía de la UNNOBA. “El formato de litigación oral sirve para todo tipo de casos, sean civiles o penales”, detalla Santamarina. En la actualidad está orientado a lo penal porque la Justicia argentina así lo requiere. El profesor aclara que “ya llegará a lo civil, porque esa es la tendencia mundial, en la cual la escritura para resolver conflictos está pasando a un segundo plano”.

En relación a sus integrantes, al comienzo eran sólo dos profesores: Pablo Santamarina y Estanislao Carricart. Al poco tiempo se comenzaron a sumar estudiantes y graduados de la UNNOBA, como Juliana Monguillot. “Ella fue alumna nuestra, entró por concurso universitario para ser docente del seminario, y ahora es la encargada de la preparación de los equipos; incluso este año va a ser evaluadora en el concurso”, cuenta. Y este año se sumó también Florencia Zandrino, junto a un equipo de alumnos ayudantes. “Es algo que va creciendo dentro de la propia UNNOBA —relata Santamarina— porque son los propios graduados y estudiantes quienes se encargan de la preparación de lo que viene. Éramos sólo dos profesores, con una materia nueva y con una perspectiva experimental”.

Concursar en un juicio

Los estudiantes se entrenan para competir en este tipo de concurso nacional. En primer lugar, considerando que “las herramientas de litigación son neutras, es decir, que para todos los casos son las mismas”. Segundo, estudiando los casos que reciben desde INECIP y sobre los que trabajarán con mayor detalle y en los cuales tendrán que asumir roles de defensa o acusación.

Los tres primeros días (lunes, martes y miércoles) afrontan un caso diferente por día y de ahí se eligen a los equipos que clasifican para la etapa final, en la que aparece el cuarto caso. “Por lo general se aborda la realidad en términos de actualidad, por ejemplo violencia de género, institucional, o vulnerabilidad. Entonces, desde el seminario se ayuda a los estudiantes a preparar el litigio del caso”, dice Santamarina.

El INECIP capacita todos los años a representantes de las universidades para que sean evaluadores y otorguen puntaje a cada universidad. Además, estos evaluadores “realizan una devolución a los equipos que compiten, indicando lo que han visto mediante una actividad pedagógica sólida, que es uno de los valores más importantes que tiene el concurso". "No importa sólo el puntaje, sino también la devolución”, destaca el profesor.

Juliana Monguillot representó a la UNNOBA como litigante en los Concursos de Litigación Universitarios en los años 2017 y 2018, luego como entrenadora del equipo entre 2019 y 2023, y este año será integrante del Comité Evaluador junto a otros catorce docentes de distintas universidades del país. La docente rememora: “Participar del Concurso cuando era estudiante me permitió poner en práctica los conocimientos que fui adquiriendo durante las distintas materias de derecho penal, especialmente en la etapa de juicio y así confirmar mi gusto por esta rama del derecho”.

“El paso por los concursos, además, me incentivó a seguir estudiando y a capacitarme en litigación —destaca Monguillot—, conocimientos que pude aplicar durante mis prácticas estudiantiles en el Ministerio Público Fiscal, lugar donde actualmente trabajo, tanto en la etapa de instrucción como también en la de juicio, especialmente en los juicios por jurados”. Además, resalta que entre sus roles está el de asistir al Cuerpo de Juicio para su preparación y también al fiscal en el debate oral. Y agrega: “Desde mi rol docente en la Universidad, también colaboro con el entrenamiento de los alumnos interesados en los concursos”.

Feliciano Larrivieri participó como estudiante en este tipo de concurso de litigación en 2023. Valora especialmente la experiencia: “Durante la competencia se genera un sentimiento de hermandad y compañerismo que es muy lindo de vivir. Se genera cierta tensión con la que uno tiene que lidiar en un escenario de simulacro, algo que también te forja como profesional”. Este año volverá a formar parte del equipo de la UNNOBA.

El sistema de jurados en Argentina

Pablo Santamarina fue atravesando las reformas y los cambios introducidos a la Justicia en estos últimos años de democracia. Desde su doble rol, como docente y fiscal provincial, afirma que el sistema de juicio por jurados llegó para quedarse: “Hay un camino trazado en esa dirección, sin vuelta atrás”.

—Hay una implementación paulatina de la resolución oral en la Justicia, pero ¿sucede lo mismo con los jurados?

—El sistema oral existe, en la provincia de Buenos Aires donde soy fiscal, desde fines de la década del 90. Se puede llevar a cabo ante jueces profesionales. Una primera diferencia es que cuando litigás ante un jurado que no conoce el caso, lo tenés que persuadir, hablar claro, presentar el caso de manera coherente, por lo tanto el nivel de exigencia es superior. Se trata ,sin dudas, del ámbito de litigio más exigente: persuadir a un jurado. En la provincia de Buenos Aires se implementó en el año 2015. Así se dio cumplimiento a un mandato constitucional y fue una forma de acercar el sistema judicial a la gente. A partir de los buenos resultados que se obtuvieron desde el 2015, muchas otras provincias se fueron sumando, se ha ido extendiendo tanto que hoy es imprescindible dentro de la formación de un profesional conocer cómo litigar en este ámbito, incluso en el ámbito civil.

—¿Qué herramientas tiene que manejar el profesional del derecho para desempeñarse en la oralidad?

—Primero, tiene que olvidarse de muchas cosas que forman parte de su saber, como hablar con términos en latín, porque es un lenguaje que nadie entiende: el gran desafío es hablar claro. Para eso, por ejemplo, hay que leer mucho todo tipo de textos que no tengan que ver con el derecho. Además, hay herramientas básicas para la presentación del caso y la formulación de las preguntas que, aunque no son difíciles de aprender, sí requieren de mucha práctica. Lo fundamental es cambiar una actitud o vicio de complejizar cosas que son simples, para así lograr convencer a alguien que no es abogado.

—¿Qué ventajas tiene para la sociedad la introducción de la oralidad y de los jurados?

—Varias. La primera es que el poder lo tiene la gente. Ante un jurado, si querés que alguien vaya preso, tenés que llevar las pruebas y es la ciudadanía la que le otorga, o no, el poder de decidir a un juez. La segunda gran ventaja es que nos obliga a ser más claros, entendibles y por lo tanto, transparentes. Esos son dos pilares fundamentales: poder y transparencia.

—En tu trabajo como fiscal, ¿te desempeñás en juicios orales?

—Sí, trabajo en juicios por jurados y en juicios orales ante jueces técnicos. Lo que se ve es que la calidad del litigio y de la preparación del caso es muy superior ante un jurado.

—¿Cómo se determina si un juicio amerita ir ante un jurado?

—En la provincia de Buenos Aires, los casos que tienen una pena de 15 o más años, en principio, van a jurado, siempre y cuando el imputado y su defensor no prefieran ir ante jueces técnicos. En otras provincias no existe la posibilidad de elegir. Las provincias han elegido empezar con los casos más graves para ir extendiendo de a poco su implementación. Por ejemplo, el proyecto de ley que se está preparando ahora desde la Nación, establece que sea para penas de 6 o más años y, si eso llegara a votarse, serían muchos más los casos en acceder al jurado. Ese proyecto de ley lo estamos estudiando algunos grupos y preparamos una devolución con algunos cambios.

—A partir de la pandemia o de casos mediáticos, hemos visto testimonios de testigos o de acusados mediante sistema de teleconferencia. ¿Qué pasa con la virtualidad y el litigio oral?

—Un juicio no se puede hacer de manera virtual. Sí se pueden tomar algunos testimonios específicos, como de alguien que esté en otro país, o realizar una consulta a un perito que esté a una distancia considerable, pero la oralidad y la virtualidad no van de la mano. Los juicios orales son, por definición, presenciales; lo que sí pueden haber son excepciones dentro del juicio. Esto se explica porque muchas de las bondades que hay en lo inmediato de lo presencial se pierden y así baja la calidad del interrogatorio y, por lo tanto, del juicio.

—Los estudiantes que ustedes van formando en litigación oral serán profesionales que dispondrán de esas herramientas para trabajar, pero ¿qué pasa con quienes se han formado en la lógica del escrito y aún están trabajando en el sistema?

—Se tuvo que empezar a desarrollar una oferta de cursos y diplomaturas de posgrado para estos profesionales, un espacio de capacitación que está creciendo, porque hay que contemplar a quienes no tuvieron este tipo de contenidos y saberes en la etapa de su formación.

Escuelas e institutos

—Una de las prácticas más interesantes, y que debe tener otro tipo de desafíos, es lo que ustedes realizan desde el seminario en las escuelas secundarias. ¿Cómo es ese proyecto y por qué lo hacen?

—Se trata de un proyecto de extensión universitaria que surge como una necesidad que advertimos junto a (Estanislao) Carricart y a Pablo Petraglia (director de la Escuela de Ciencias Económicas y Jurídicas), cuando pensamos en lo poco que se conoce del juicio por jurados en la sociedad. Y la preocupación venía, sobre todo, al tener en cuenta que es un sistema que rige en doce provincias argentinas en las que vive el setenta por ciento de nuestra población. Por lo tanto esas personas pueden formar parte de un jurado o pueden ser juzgadas por un jurado. En consecuencia pensamos en la manera de mostrar el funcionamiento de este tipo de juicios. Así fue que presentamos un proyecto de extensión, aceptado hace dos años.

—¿Lo hacen con estudiantes del seminario?

—Sí, junto a estudiantes del Seminario de Litigación hacemos simulacros de juicio por jurado en las entidades que nos invitan. Por ejemplo, si es una escuela secundaria, son los alumnos los que forman el jurado y tratamos de que los casos tengan actualidad y vigencia. Y nuestros estudiantes son fiscales, defensores, acusados e incluso a veces jueces, así no se les adelanta nada del caso. Se hace un simulacro, una actividad de dos horas y media y son ellos, como jurado, quienes deciden. Después hablamos sobre qué les pareció la experiencia y les comentamos más sobre el funcionamiento del sistema. Lo hemos hecho en escuelas secundarias de Pergamino y de Junín y con la Secundaria “Domingo F. Sarmiento” de la UNNOBA. También hemos estado con la escuela de policía y terciarios de la región. Para estas tareas se ha sumado, de una manera fundamental, el equipo de Litigación Pergamino, un grupo de profesionales locales preocupados y ocupados por mejorar la litigación en nuestro departamento judicial.

Santamarina finaliza destacando algo que permite a la universidad seguir creciendo: “Este tipo de propuestas nos permite mostrar lo que es la UNNOBA y su nivel universitario a la sociedad”.

Diseño: Laura Caturla

¿Enseñar con inteligencia artificial?

Por Marcelo Maggio

¿Cómo enfrentará el sistema educativo los desafíos que le presenta la inteligencia artificial (IA) generativa? ChatGPT, Copilot, Gemini, son sólo algunas de las herramientas más difundidas que, a la vez que masifican su uso, permean en las aulas a gran velocidad.

Con cada nueva capa de tecnología digital se introduce un renovado desafío para la educación. Desde poder pensar la existencia misma de una computadora dentro del aula, pasando por la conectividad a la red de redes, el uso indiscriminado del “dios Google” o la recurrente Wikipedia como la fuente de todos los trabajos prácticos. Sin embargo, hoy parece que el monstruo que emerge del océano es bien diferente a todos los anteriores. Por eso la respuesta no demora y ya se están pensado pedagogías que contemplan nuevas prácticas y que incluyen a la inteligencia artificial, que pareciera extender su sombra como una amenaza de extinción por toda la geografía donde pase.

La inteligencia artificial generativa puede producir "cosas”, ya sean textos coherentes como hace ChatGPT, u otro tipo de contenidos como imágenes, audio, video, presentaciones de diapositivas, programas, diseños web, recetas de cocina… desde las plataformas que van surgiendo a medida que el negocio lo promete. Este nuevo paradigma de aprendizaje, el generativo, para el caso del lenguaje se “entrena” mediante la ausencia de palabras y realiza predicciones sin la participación de un humano que le indique cuál es el significado o qué debe hacer con ese tipo de información.

Algunos intelectuales, como el filósofo Diego Levis no dudaron en plantear sus críticas desde el inicio: “Hace muchos años que los sistemas informáticos avanzados («inteligencia artificial») participan activamente en nuestras vidas aunque su expansión ha sido inicialmente imperceptible”. El problema, la crítica, posa en su implementación actual, ya que "son utilizados para influir, condicionar y dirigir de un modo sofisticado y casi imperceptible nuestros gustos y nuestros deseos, ideas y comportamientos”.

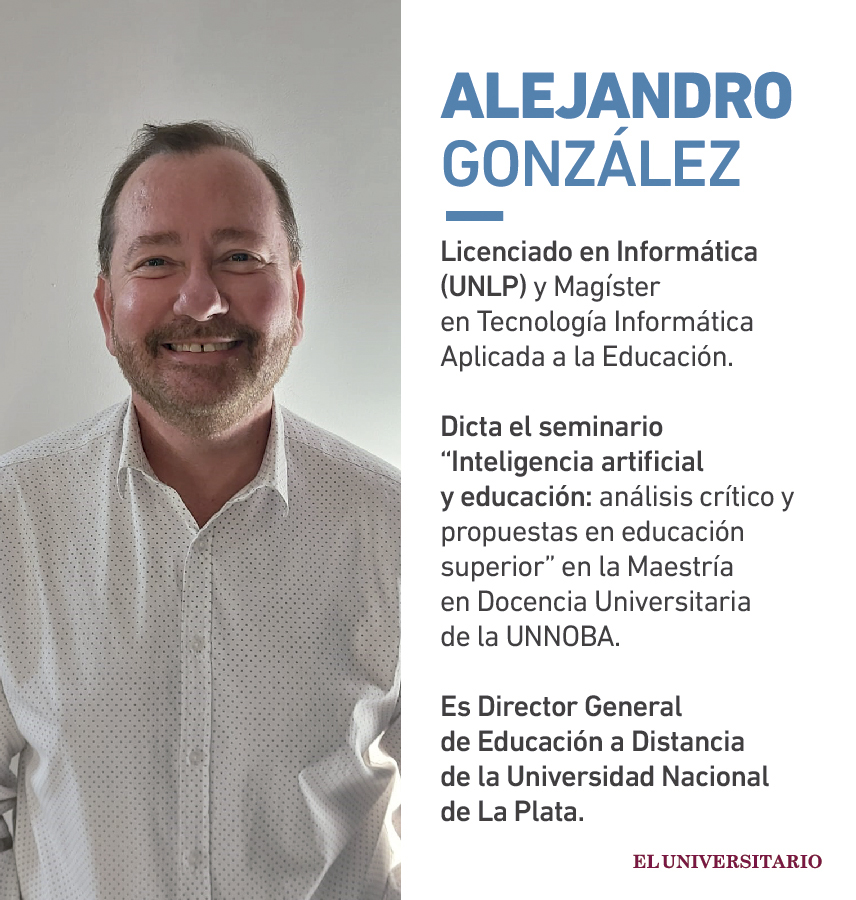

Es por eso que desde las instituciones educativas se está pensando en dar respuesta a los nuevos desafíos. ¿Qué hacer, dejarse llevar por la ola? Alejandro González es docente en el seminario “Inteligencia artificial y educación: análisis crítico y propuestas en educación superior” de la Maestría en Docencia Universitaria de la UNNOBA. Este profesor afirma que “los estudiantes ya están usando la IA, para estudiar y para hacer tareas, y por eso es necesario mantener el poder de decisión y de crítica, para no creer que todo lo que te responde es la verdad absoluta”. En 2023 desde The New York Times se advertía sobre una de estas aristas: “La inteligencia artificial a veces alucina, es decir, inventa cosas. Y estos errores pueden ser simplemente decepcionantes o, por el contrario, tener consecuencias devastadoras para algunas personas”. (Elda Cantú, en el sitio de Diego Levis aquí).

En esta entrevista, el responsable del área de Educación a Distancia de la Universidad Nacional de La Plata (UNLP) parte de pensar la tecnología educativa desde una línea histórica general, que puede iniciar en el libro en papel y seguir hasta los medios masivos tradicionales. Sin embargo, González enfatiza en la necesidad de hacer foco en lo digital: “Incluimos todas las tecnologías, pero puntualmente la digital, pensada en la relación que se da con los procesos educativos. En este sentido, la irrupción de la inteligencia artificial generativa es la tecnología que está siendo más analizada, probada y puesta en perspectiva desde el año pasado”.

Frente a la dicotomía “amenaza o revolución”, que impondría la nueva inteligencia artificial sobre la educación, González plantea que hay que asumir que estamos ante "una tensión permanente” y no frente a una dicotomía.

Las tecnologías del conocimiento vigentes no tendrían por qué sentirse amenazadas sino que habría que encontrar su nuevo lugar en un escenario reconfigurado. “Todas las tecnologías de la educación forman parte de lo que la persona utiliza para aprender, y hay que identificar que son distintas. Podemos elegir un libro y preguntarle a la inteligencia artificial cuál es la idea principal del autor, y quedarnos con eso. Pero la experiencia de leer el libro completo no la puede reemplazar, y mucho menos esa fascinación de tenerlo en la mano, por ejemplo”, asegura González, magíster en Tecnología Informática Aplicada a la Educación.

Desde su experiencia como docente, González advierte algo que podría pasar inadvertido pero que en un proceso histórico puede tener consecuencias diversas: “Hay una tendencia a la virtualización de los objetos. Esto es parte de algo más profundo, que tiene que ver con cómo el mundo imagina su futuro”.

La problemática excede al debate educativo, pero dentro de su esfera aparece con claridad con el avance de los "entornos digitales", y se la puede pensar en los términos más amplios de un nuevo estatus del régimen de la materialidad y el mundo de las cosas.

González es docente de grado y posgrado en diversas universidades, y afirma que en sus cursos se ponen “todas las tecnologías sobre la mesa y ahí es cuando aparece lo interesante”, mediante esa interacción con las tecnologías. “Más allá de la posición de cada uno, tratamos de que se pueda comprender qué es una tecnología digital y qué está reemplazando y, sobre todo, si ese reemplazo es el más adecuado, o no, para el proceso educativo”.

Tecnologías educativas, un camino

La tecnología digital educativa tiene su recorrido y los desafíos no comenzaron con ChatGPT. González rememora: “Cuando en los 80 aparecían las primeras computadoras, y se hablaba de la computadora en el aula, parecía algo imposible. Luego hubo una primera impronta en los 90, que fue marcada por internet y su apertura para mejorar la comunicación y distribuir la información. La educación a distancia permite entenderlo mejor, porque fue la primera forma que tuvo la educación de incorporar estas tecnologías, porque las necesitaba, desde el momento cero, cuando se deja de pensar en revistas, fascículos o televisión y se empieza a pensar en que hay otro medio para distribuir el conocimiento”.

Estos antecedentes desembocan en lo que se conocen como entornos virtuales de enseñanza aprendizaje, un espacio réplica del aula física denominado “aula virtual”. Desde los años dos mil, aparece el híbrido, el aula que va más allá de las cuatro paredes gracias a las nuevas tecnologías. Internet y la computadora en el aula van llegando al aula gracias a programas como fue Conectar Igualdad en Argentina (2010). Y también el debate sobre el uso de las redes sociales con fines educativos (2015).

Un recorrido que llega hasta la pandemia y ahí se pone a prueba. “En la pandemia se produce un quiebre —afirma González— porque la hibridación que faltaba era la videoconferencia. Lo que termina de hacer esta aparición es dar cuenta de que hay otra manera de enseñar y que no es teniendo al alumno dentro del aula, algo que no era una novedad, pero que no se hacía por falta de aceptación”. La necesidad llevaba a la herejía.

“La no aceptación es parte de la dinámica habitual de los procesos educativos, porque son procesos lentos, y fue necesaria una situación extrema como la pandemia”, reflexiona. Y agrega: “Aunque hubo retrocesos, la tecnología sigue avanzando, es inevitable, y el hito que viene ahora es la inteligencia artificial generativa”. Por eso, “es un buen recurso para pensar qué tecnologías elegir y qué formas de trabajo hay que dejar atrás”. “Este cambio de lo que requiere es mucha planificación y preguntarse para qué, cuáles son las necesidades y qué tecnologías se utilizan”, sintetiza González.

Preguntarnos cómo funciona

—Muchas veces las tecnologías emergentes se introducen en el aula casi por la ventana, porque ya se usan o porque todos hablan de eso. ¿Cómo enfocar este problema desde instituciones que tienen lógicas distintas a la del mercado?

—Pensando en el seminario de la maestría, lo primero que tratamos de hacer es plantear que debemos entender cómo funciona. Como con cualquier tecnología, para saber manejarla hay que saber cómo funciona. La segunda vuelta es probarla, empezar a usarla y ver para qué sirve. Recién después podés pasar al plano de la planificación didáctica. ¿Creemos que se puede usar tecnología de inteligencia artificial generativa en el aula? Sí. Pero lo que necesitamos es que la prueben y la usen primero los docentes. Por ejemplo, hay que saber preguntarle y repreguntarle a una IA. Esa es una parte del seminario. La otra parte es la cuestión ética, no sólo los problemas típicos que preocupan a la docencia, como la copia y el plagio, sino acerca del contenido y las ideas que se introducen, porque debemos pensar en quiénes entrenaron a esa IA y con qué material. Si uno puede interpretar que hay un sesgo, volverá a preguntar y hacerla responder de otra manera. Es el mismo sesgo que tenemos nosotros, claro, porque es algo creado por humanos.

Alejandro González destaca que es un tema preocupante relacionado con los usos de la inteligencia artificial generativa y que por eso intentan abordarlo puntualmente en el seminario de posgrado, “para poder pensar actividades que enseñen a los estudiantes un buen uso de la IA”.

“Lo planteamos de este modo porque sabemos que los estudiantes ya están usando la IA, para estudiar y para hacer sus tareas. Por eso destacamos que es necesario mantener el poder de decisión y de crítica, para no creer que todo lo que responde la IA es una verdad absoluta”, afirma. Y en este sentido les insiste a sus colegas docentes: “El mayor problema que podemos encontrar es el uso indiscriminado, que lamentablemente va a pasar, como pasa con las redes sociales, el mal uso. Somos los docentes quienes podemos resolver estos problemas, no queda otra”.

—¿Por qué se está hablando de una alfabetización digital? A inicios del siglo XX la alfabetización era un concepto centrado en la lectoescritura. Sin embargo en la actualidad se plantea que esta nueva capa tecnológica requiere de una alfabetización específica.

—Creo firmemente que la alfabetización digital es algo central. Desde hace tiempo venimos planteando que es un elemento más a incorporar. Nosotros lo hacemos a nivel universitario, lo hacíamos en su momento cuando enseñábamos a usar un buscador de internet. Le podemos decir alfabetización mediática o informacional, pero ese es el punto al cual tenemos que ir: lo vienen planteando UNESCO y UNICEF, pero no termina de plasmarse.

—¿Alguna hipótesis de por qué no se logra avanzar en este sentido?

—Creo que la tecnología digital no lo logra porque tiene la tendencia, más que otro tipo de tecnologías, de volverse invisible, transparente, en el hacer diario de las personas, y eso genera que sea complejo poder entenderla, porque si muchas cosas no las vemos, entonces las iremos perdiendo en tanto son un objeto tecnológico. Considero que es importante la alfabetización digital en todos los niveles educativos y que podría ser, incluso, una asignatura. ¿Por qué? Porque existe un pensamiento computacional, poder pensar en qué es lo que está pasando ahí, en esa máquina, que funciona de una manera diferente a la de nuestro razonamiento habitual. Son ejes que debemos pensar para incorporarlos desde la temprana edad y acompañarlos debidamente en su evolución.

—En tiempos de la prepandemia, desde la Fundación Sadosky, el espacio denominado Program.AR, el Instituto Nacional de Educación Tecnológica (INET), entre otros, se planteaba algo similar, en esta línea. Decían que se tenía que incorporar "programación" como asignatura a los planes de estudio de la educación obligatoria, al nivel de matemática o lengua. Vos, que también enseñás programación, ¿estás de acuerdo?

—Estuve en ese debate. Incluso uno de los informes de UNESCO, “Educación 2030” (y también desde este documento puntual), solicita que se incorpore la enseñanza de la programación como tema. Creo que va en línea con lo que decimos. Para poder entender estas tecnologías no alcanza con los saberes que se brindan actualmente, porque hay algo del razonamiento que se le pone a la tecnología digital que no está presente en otras disciplinas. Sigue siendo un faltante. Aunque hay escuelas de nivel medio que enseñan tecnología digital, pero desde lo herramental, es decir aprender a usar tal programa, hay que ir más allá. Se discutía a inicios de los 90 que la programación era algo elevado para el nivel medio, se mencionaba a Piaget y las capas para el razonamiento. Pero hoy vemos que estudiantes de 6 o 7 años pueden programar. Y en este sentido, lo que notamos en nuestras carreras de informática es que los estudiantes alcanzan un mayor nivel de comprensión sobre cómo funciona esta tecnología cuando hacen programación de computadoras.

La soberanía, ¿un término del pasado?

—Genera curiosidad saber cómo queda la temática de la "soberanía digital" frente al nuevo escenario que nos impone la IA de los gigantes tecnológicos. Hubo desarrollos, por ejemplo en el marco del programa Conectar Igualdad, que apuntaron a esa idea. En el presente la problemática de la soberanía aparece borrosa, en parte porque cada vez estamos más atravesados por los recursos que nos proponen las grandes tecnológicas del mundo. ¿Se puede continuar reivindicando la soberanía digital o ya hemos quedado muy atrás en el desarrollo tecnológico y en el discurso político?

—Yo creo que sí hay que retomarlo. No tenemos un contexto político del país que lo favorezca, absolutamente para nada, todo lo contrario. Tenemos un mal momento político, donde cualquier propuesta de soberanía digital no va a ser bien vista ni entendida. Al revés, traemos la distribución de internet mediante Elon Musk, pero no va por ahí la cosa. Desde las universidades podemos hacer mucho por la soberanía digital. Los Estados tienen que tener sus propios desarrollos, tanto en IA como en otros campos. Acá no hay ningún proyecto que yo conozca que esté pensado para dar cuenta de esto. ¿Hay desarrollos puntuales y locales? Sí, claro, por ejemplo desde una materia estamos desarrollando un chatbot con toda la complejidad que te imagines, porque no quiero que utilicen ningún servicio externo, queremos que sea un servicio nuestro, de la UNLP. Ahí vos ya tenés una primera mirada sobre la soberanía. Claro, eso es David contra Goliat, pero son los Estados los que deben fomentar el uso de tecnología digital pensando en la soberanía: cuidado de datos, recursos, servidores propios. Por ejemplo, los datos de los estudiantes los tenemos en nuestros propios entornos virtuales, siempre nos negamos a comprar una plataforma externa. ¿Quién tiene los datos, quiénes los administran? Somos nosotros. Por más extraño que parezca el momento que estamos viviendo, creo que la soberanía digital no está perdida, para nada. Si primero la lucha por soberanía fue territorial, cuando se quieran dar cuenta la disputa va a ser por los datos.

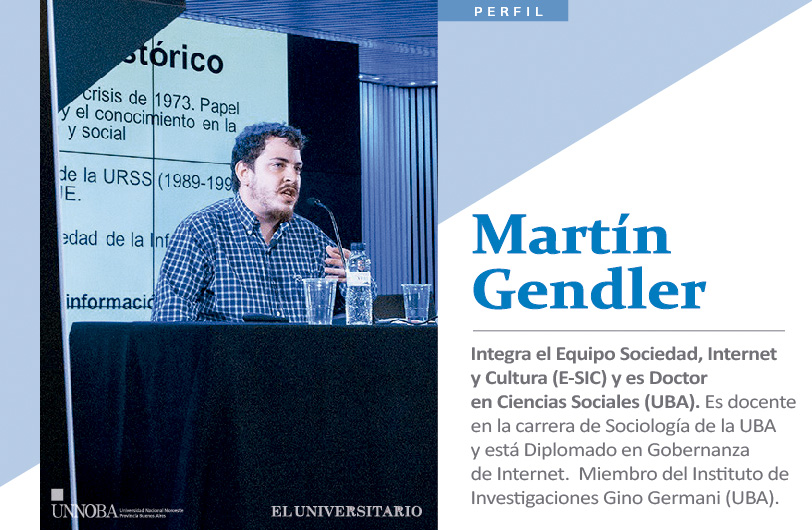

“En la inteligencia artificial hubo una revolución”

Por Marcelo Maggio

Cuando Juan Pablo Tessore empezó a estudiar la carrera de Ingeniería en Informática en la UNNOBA corría el año 2006. Para ubicar el frenesí de la historia si se mira desde el prisma digital, se pueden citar algunos datos de color. Lo ubicamos como el año en que Google adquiere una pequeña pero prometedora plataforma para subir videos: YouTube. También fue el año en que aprendimos a tuitear. Y para decorar, en diciembre Steve Jobs deslumbró a un grupo selecto revelando su nueva creación, el iPhone.

La inteligencia artificial ya era un campo de investigación que venía pidiendo pista desde hacía muchos años, pero seguía siendo un tema de especialistas, algo lejano a los usuarios de a pie, de la prensa masiva y de las cotizaciones en bolsa. En 1950 Alan Turing escribió un breve artículo en el que se preguntaba “¿pueden pensar las máquinas?”, y encendió la mecha. Su exploración fue sumando cada vez más adeptos; Juan Pablo Tessore se inscribe en esa historia con su labor.

“Modelado e implementación de algoritmos inteligentes de análisis de opinión” es el título de su tesis, presentada en la Facultad de Informática de la Universidad Nacional de La Plata para el Doctorado en Ciencias Informáticas. Con este trabajo, defendido y aprobado en septiembre pasado, Juan Pablo Tessore se convirtió en el primer graduado de la Escuela de Tecnología de la UNNOBA en obtener un título de doctorado. Para Mónica Sarobe, directora de esta unidad académica, “Juan Pablo representa la importancia de la formación continua, algo central en cualquier disciplina pero en especial para las relacionadas con la tecnología, porque ha dejado de ser una alternativa para pasar a ser una prioridad”. “Esta titulación, sin duda, redundará en mejoras tanto para nuestro proceso académico como para la investigación”, destaca la directora de la Escuela de Tecnología.

Tessore nació en Junín y deseaba estudiar informática sin alejarse de los suyos: “Empecé a tener contacto con estudiantes que ya cursaban en la UNNOBA y les consulté cómo era la carrera; tuve buenas opiniones sobre lo académico y respecto de los profesores también. Eso me convenció. Además, está la parte de los afectos, el hecho de tener a mi familia y a mis amigos acá. Tenía todos los beneficios sin los costos de irme”.

Mientras estudiaba, comenzó a desempeñarse como ayudante alumno en la materia “Bases de datos”, hasta que finalizó su carrera de grado como ingeniero en Informática, en 2011. Trabajó para el sector privado en diversas empresas, pero la Universidad siempre estuvo presente para él. Siguió un tiempo como docente desde las materias “Lenguajes de programación” y “Compiladores”, hasta que la curiosidad y las elecciones de la vida lo llevaron a dedicarse por completo a lo académico. Inició los estudios de un doctorado y se puso nuevamente al frente en las aulas de la universidad en los cursos de las materias “Compiladores” y “Sistemas inteligentes”.

En la búsqueda de la inteligencia artificial

Para empezar su doctorado tenía que presentar una propuesta. Tessore confiesa que siempre estuvo enfocado en el mismo tema, aunque implicara estar en el ojo del huracán: “En nuestra rama, en este tiempo, hubo una revolución y nos tuvimos que adaptar, aunque siempre estuve concentrado en la inteligencia artificial que estudia el aprendizaje automático, el procesamiento del lenguaje natural y el análisis de sentimientos y opiniones”.

Cuando el mundo digital estaba viviendo la fiebre de las apps en los dispositivos móviles, Tessore hizo su apuesta personal por la inteligencia artificial. Cuenta que pudo ver cierta tendencia y sentía que tenía que explorar por ese camino porque “había algo que iba a explotar”. Para él, “es un área que trae muchísimos beneficios y riesgos. Los beneficios de la automatización de tareas son evidentes, tareas que pueden ser tediosas, incluso riesgosas para las personas y que solucionadas por la automatización traen beneficios económicos claros”.

“A inicios de 2017 hice un intercambio en España, estuve en Zaragoza y en Madrid. Los investigadores de allá me plantearon que no había recursos para entrenar clasificadores basados en aprendizaje automático para el análisis de sentimientos y opiniones en el idioma español”, recuerda. Este tipo de herramientas estaban muy avanzadas para el idioma inglés, pero en español la investigación estaba rezagada. Así fue que arrancó su propuesta.

¿Pero qué implica todo este tema del aprendizaje automático? Tessore lo explica así: “Es una rama de la inteligencia artificial que se centra en desarrollar algoritmos que puedan aprender a partir de los datos y, para nuestro idioma, faltaban muchos recursos, entre los que podemos encontrar los denominados 'datasets etiquetados'. Desde el Instituto de Investigación y Transferencia en Tecnología (ITT) de la UNNOBA trabajamos para recopilar textos de redes sociales y diseñar una metodología para clasificarlos de manera semiautomática y, a su vez, validarlos”. Esos datos servirían para entrenar a los algoritmos.

“Los resultados fueron buenos”, afirma Tessore, “y determinaron que los clasificadores entrenados por el equipo del ITT tenían un rendimiento similar a lo que estaba presente en los otros idiomas”. Pero había más: “Creamos una metodología que permitía crear esos datos de entrenamiento de manera mucho más ágil, sin la intervención de una persona que lo haga todo de manera manual”.

Las implicancias de este cruce entre IA y lenguaje aún nos siguen sorprendiendo. “Por ejemplo, estas herramientas se pueden usar para un análisis automático de opiniones de un producto en venta al revisar los comentarios en una plataforma online, lo mismo podría usarse para los comentarios durante una transmisión en vivo. Por lo tanto, el objetivo es analizar un texto informal que aparece en una red social y obtener resultados”.

Procesamiento del lenguaje natural se denomina a la rama de la inteligencia artificial que se ocupa de la interacción entre las computadoras y el lenguaje humano, algo que despertó las alarmas de los críticos, como la del best seller Yuval Harari. “La IA tiene la capacidad de hackear y manipular el sistema operativo de la civilización. Al adquirir el dominio del lenguaje, la IA se ha apoderado de la llave maestra de la civilización, capaz de abrir desde las bóvedas de los bancos hasta los santos sepulcros”, declaró para The New York Times el filósofo.

Esta interacción entre computadoras y lenguaje humano puede trabajar sobre texto escrito, pero también se puede orientar hacia algo mucho más arriesgado como es la generación y comprensión de voz humana. Tessore advierte que su trabajo apunta hacia lo textual, como lo que podemos ver en ChatGPT: “Eso es el procesamiento del lenguaje natural, cuando interactuás con una herramienta y puede parecer que se trata de una persona”.

“Creo que cualquier tarea va a tender a estar basada en este tipo de interacción con el lenguaje natural. Por ejemplo, las empresas están invirtiendo mucho en pasar de los chatbots tradicionales hacia este modelo, ya que la diferencia es enorme”, explica. Pero hay riesgos que asumir al atravesar ese umbral, como los nuevos tipos de problemas que aparecen a nivel de seguridad. Tradicionalmente los ataques informáticos tenían que ver con un dominio muy profundo de la técnica computacional. Sin embargo, expertos como el español José María “Chema” Alonso afirman que el hacking actual se basa más en un uso creativo del prompt (cuadro o vía) de diálogo con una IA que en las técnicas tradicionales. Para esto, “hay que estudiar más psicología que programación”. En criollo, el nuevo hacking está más cerca del cuento del tío que de pantallas llenas de código.

La investigación, un camino

—¿Cómo vivís la experiencia de investigación en un área que es tan amplia y cambiante?

—En esta disciplina siempre me dediqué al software y al pensamiento abstracto; eso es lo que te permite la programación y no tanto lo que es el trabajo con hardware. Cuando empecé a estudiar se veían algunos cambios, sobre todo los relacionados con la masificación de internet y con los nuevos dispositivos. Pero, al elegir esta carrera, mi objetivo fue siempre formarme en algo específico y que me gustara. Y aunque estuve unos años trabajando en el sector privado, decidí volver para seguir estudiando y hacer investigación, algo que pasó gracias a la insistencia y el ofrecimiento de Hugo Ramón (prosecretario TIC de la UNNOBA).

—¿Cómo evaluás el nivel académico de la investigación informática en nuestro país?

—Hace poco hablaba con un colega que trabaja en una empresa del exterior y me decía que buscaban especialmente gente de Argentina por el buen nivel técnico que hay en informática. Y no es la primera persona que me lo dice. Mi directora de tesis, que es argentina y vive en Europa, insiste en que le gusta sobre todo colaborar con los proyectos de nuestro país por el buen nivel que hay. Son ejemplos, pero creo que nos ayudan a ver dónde estamos.

—¿Alguna hipótesis de por qué sucede eso?

—Creo que hay una presencia importante de carreras y programas de formación e investigación en el país. Mi carrera de grado la hice sin pagar nada y tuve acceso a una educación excelente, con docentes del ámbito local y también de otras ciudades, una tradición que creo nos da una posibilidad que en otros países no existe. Hoy tengo cantidad de compañeros egresados de la UNNOBA que están insertos en la industria, y aunque por ahora soy el único que terminó el doctorado, destaco que también están Leonardo (Esnaola) y Benjamín (Cicerchia) finalizando los suyos.

—¿Cómo sigue tu labor a partir de ahora?

—Partiría de tomar el surgimiento y desarrollo de estos grandes modelos del lenguaje y me gustaría utilizar alguno de ellos para aplicarlo en optimizar tareas en alguna institución. Por ejemplo, para la asistencia en los sistemas de enseñanza dentro de las aulas virtuales, o incluso dentro de una empresa en un sentido más amplio, para optimizar procesos.

—A nivel nacional, ¿qué tipo de desarrollo hay en inteligencia artificial?

—Hay muchos grupos de investigación abocados a la tarea. Lo que hay que tener presente es el gran financiamiento que tienen las empresas que están hoy en boca de todos, y por eso el crecimiento que han tenido. De hecho, en los últimos congresos a los que asistí, un tema que se ha debatido es que tenemos que involucrarnos para que estas herramientas dejen de ser una “caja negra”, porque no sabemos qué es lo que hacen para dar las respuestas. Y si las integramos a los procesos productivos sería bueno poder explicar por qué se toman las decisiones, para que no sea algo arbitrario. Es necesario que los investigadores que estamos en las universidades del país nos involucremos en esto para poder crear herramientas similares a las que ya hay, que sean más transparentes y que sepamos cómo funcionan. Esto es crítico si pensamos integrarlo a la vida social, por eso las instituciones públicas y el Estado tienen un rol que cumplir en eso.

—¿Existe un espacio específico desde el cual debatir sobre IA en nuestro país?

—Por el momento, tenemos los congresos de informática, como el Whorkshop de Investigadores en Ciencias de la Computación (WICC) (el último se realizó en la UNNOBA) y el Congreso Argentino de Ciencias de la Computación (CACIC 2023). En ambos espacios hay líneas abocadas a la inteligencia artificial. De hecho, yo estuve en un panel sobre IA y educación en el último CACIC. Pero creo que el auge del tema hará que surjan más espacios para debatir y planificar tareas.

Práctica profesional: el desafío del mundo del trabajo

Por Marcelo Maggio

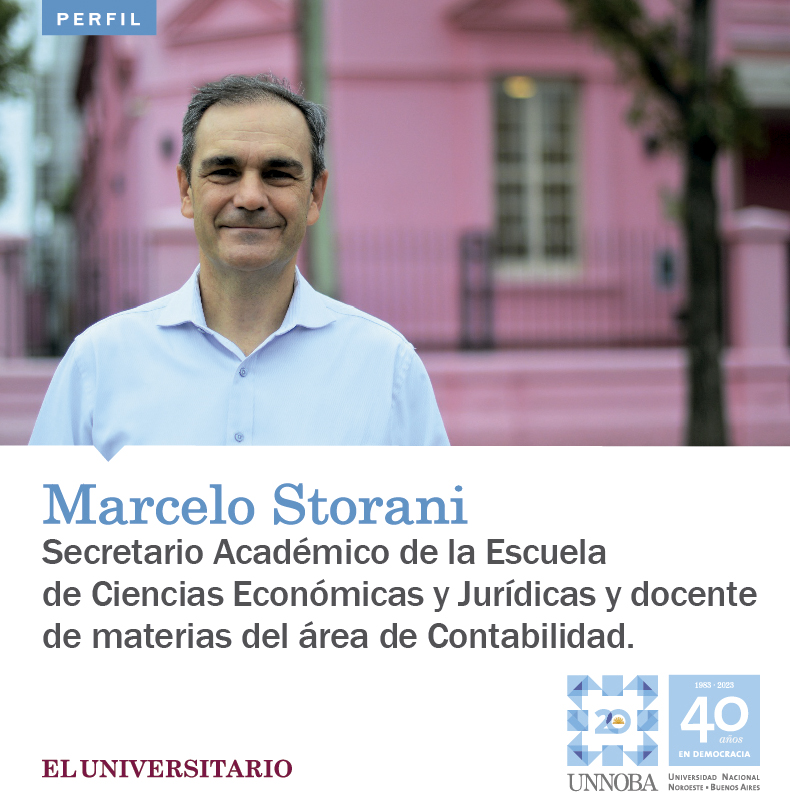

La estrategia de implementar Prácticas Profesionales Supervisadas (PPS) se extiende en el sistema educativo y son cada vez más las carreras que a nivel nacional deciden incorporar este modelo de finalización de la cursada de grado. Ante la demanda social por acercar teoría y práctica, el sistema universitario argentino fue desarrollando cambios en los planes de estudio que permitieron crecer en este sentido.

“Desde 2017 todas las universidades que dictan la carrera de Contador tienen la obligación de acreditar nuevos planes de estudio”, explica Marcelo Storani, secretario Académico de la Escuela de Ciencias Económicas y Jurídicas y docente de materias del área de Contabilidad. El procedimiento para las reformas, sea en esta carrera o en otras, incluye tanto a las universidades como a las instancias nacionales que dependen del Ministerio de Educación con el objetivo de “integrar conocimientos académicos con la realidad profesional”. “Las PPS son, además, un mecanismo de evaluación de la institución junto a la comunidad, porque aparecen empresas y organismos públicos que le brindan espacios al futuro graduado, son un estímulo y, además, estas prácticas permiten encontrar distancias, diferencias, problemas, entre la demanda social y la oferta académica”, sostiene el funcionario.

En agosto de este año comenzó la cursada del seminario en materia jurídico tributaria, a partir de un convenio con la Administración Federal de Ingresos Públicos (AFIP), una práctica que les permite a los estudiantes de Abogacía y Contador cumplir con las 100 horas previstas, tanto en Junín como en Pergamino.

Storani detalla que se trata de un recorrido con teoría y práctica: “Se utiliza la plataforma de AFIP para el desarrollo de trabajos prácticos sobre cada uno de los impuestos que se estudian, con casos reales, quitando los datos sensibles. Luego el estudiante tiene que elegir un tema y desarrollarlo ante un jurado, así se recibe, esa es su última materia”.

El nuevo plan de estudio para la carrera de Contador data del año 2018 y contiene la obligatoriedad de culminar la carrera con 100 horas de práctica. Y en Abogacía ya estaba prevista esa práctica, que atravesó varias reformas. “Tenemos varias modalidades para cumplir esas horas. Una de ellas es la tradicional tesina, que consiste en la investigación de un tema —relata el docente—. Pero ahora también tenemos la interacción con las empresas y organismos mediante estas prácticas, que implican la firma de convenios con cada uno”. En particular, Storani destaca este convenio con AFIP porque la modalidad de seminario permite hacerlo de modo grupal, con una docena de estudiantes que practican todos juntos.

Además de ir abordando cada uno de los distintos tributos y temas (desde la relación entre sistema tributario y el los poderes del Estado hasta temas específicos como monotributo, relación de dependencia o cargas según el sector productivo) con docentes y funcionarios del organismo, luego los estudiantes realizan una visita guiada al organismo, donde se entrevistan con los responsables de cada sector, desde atención al público y revisión de recursos hasta la parte jurídica, de particular interés para estudiantes de Abogacía. Aunque hacen el seminario de manera separada, la Universidad mantiene una relación entre lo jurídico tributario y lo estrictamente contable tributario.

Derecho y economía

—¿Cómo funciona lo jurídico tributario? Es decir, ¿cómo es esta práctica para los abogados?

—En el organismo está la parte jurídica. Cuando uno tiene, como contribuyente, un proceso de fiscalización, puede impugnar o puede presentarse con una disconformidad ante el organismo. Existe un cuerpo de abogados de AFIP que analiza el pedido que hace el contribuyente. Lo admite o lo rechaza. Si se lo rechaza, el contribuyente tiene la posibilidad de ir a un tribunal fiscal, salir de la órbita de AFIP e ingresar a la esfera judicial, seguir así un proceso en un tribunal.

—Es decir que sólo abordan litigios y conflictos.

—Exactamente. AFIP tiene muchísimos abogados trabajando, casi la misma cantidad que contadores.

—¿Ese nivel de conflictividad es normal, es algo exclusivo de Argentina?

—El conflicto es permanente. En materia tributaria existen plazos y recursos. Son dos instancias distintas: lo administrativo y lo judicial. Y es algo normal, en todos los países existe. Muchas veces extender el conflicto permite no pagar, extender el tiempo, quizás conseguir una moratoria. O mantener la expectativa de un fallo a favor porque pudo existir algún error en el proceso de fiscalización por parte de los agentes.

—¿Cómo es la obligación de la práctica en la carrera de Abogacía?

—Es algo previsto en el plan de estudio. Y estas prácticas orientadas a la experiencia profesional equiparable nos permiten que el futuro egresado se adelante a la vida laboral, tenga contacto con el no sólo con el Poder Judicial, sino con una empresa o un organismo, como en este caso, para así mejorar la formación cuando finaliza su carrera. Pero también las prácticas tienen otra ventaja, por ejemplo para estudiantes de distintas localidades que terminaron la cursada y que pueden hacer estos trabajos en su lugar de origen. Entonces se vincula a la Universidad con los diversos distritos de la región.

Impacto académico y salida laboral

“Las PPS también nos han dado la satisfacción de poder vincular al estudiante con una primera salida laboral —indica con gusto el profesor Storani—, porque allí, en esa práctica, suelen encontrar su primer trabajo como premio a su desempeño”.

Claro que para realizar un trabajo en el marco de una PPS se tienen que dar una serie de acuerdos legales que no son improvisados. Es un trabajo que se da mediante la firma de un convenio específico entre un empresa/organismo, la universidad, el estudiante y los tutores, “porque se designa un tutor por el lado de la empresa y otro por el lado de la universidad”. Todo esto permite pactar “un plan de trabajo, donde figura qué es lo que tiene que realizar el estudiante en ese trayecto formativo durante el cumplimiento de las horas”.

Así se puede garantizar que se trata de una práctica formativa y no de una simple utilización de mano de obra gratuita, o un uso improductivo del tiempo estudiantil. Storani, como secretario Acedémico de la Escuela, tiene una visión amplia y estratégica del tema.

—Este tipo de cambios en la formación era algo que aparecía en los discursos públicos. Se pedía una formación que no estuviera tan apartada de la práctica, ¿usted lo ve así también?

—Claro. Cuando me recibí hace treinta años, también reclamábamos esto. Y por eso también buscamos que las carreras de grado se acorten, tener planes de estudio con menor carga horaria, que esa carrera esté más cerca de la práctica profesional del graduado; que brinde una formación generalista para luego seguir mediante el posgrado y la formación permanente enfocados en el área que más le interesa o que le brindó la oportunidad laboral, que muchas veces pueden ir de la mano.

—¿Estas reformas también impactan o se orientan en ampliar la base de estudiantes graduados?

—Entre otras cosas, se busca achicar la deserción y acortar el período de graduación. Los promedios de graduación pueden llegan al doble de lo estimado por el plan de estudio, y eso no es bueno, esa dilación, por eso buscamos acompañar a los estudiantes ya desde el inicio. Por ejemplo, en los primeros años de la carrera buscamos, sobre todo, que no se abandone haciendo seguimientos y ofreciendo más opciones de cursada a quienes tuvieron problemas.

—¿En estas carreras también son los primeros años los más críticos en términos de deserción?

—Sí, lamentablemente. En primer año la deserción puede llegar al cincuenta por ciento. Y se se dan muchas cosas como para poder analizar, desde que la base que un estudiante trae de la secundaria, que nunca alcanza, hasta el tema vocacional, porque cursando se pueden dar cuenta de que en realidad buscaban otra cosa. Ahí lo que tenemos que hacer es acompañar esos procesos de búsqueda.

Relación con AFIP, el rol del Estado y los impuestos

—¿Cómo es la génesis de esta práctica profesional en concreto, cómo llega la Universidad a articular con un organismo de la dimensión de AFIP?

—Desde hace más de diez años AFIP tenía un convenio con la universidad mediante el cual se dictaban seminarios de cultura tributaria. Eran cursos abiertos, no formaban parte de la currícula, y tenían como objetivo generar conciencia en el estudiante. Luego, hace unos seis años, aparece la idea de los “núcleos de asistencia fiscal” (NAF) y para eso participé en un programa de capacitación en la casa matriz de AFIP, dentro del Ministerio de Economía. Los NAF eran como "minioficinas" del organismo dentro de las universidades donde el estudiante trataba de atender y colaborar los ciudadanos. Pero este proyecto no prosperó por diversas cuestiones propias del organismo. A partir de estas experiencias pasadas, del buen vínculo que veníamos teniendo, y teniendo en cuenta que varios funcionarios de AFIP a nivel regional ya eran graduados UNNOBA, pensamos desde Junín armar este seminario, con características bien específicas. Desarrollamos un programa, lo presentamos a AFIP para que sea aprobado y lo vieron bien. Incluso lo tomaron como ejemplo de experiencia para replicar en otras agencias de AFIP para el resto del país.

—AFIP es un espacio para la práctica y la formación en un momento histórico en el cual el concepto de impuesto aparece en el foco de la crítica política, hasta lo impositivo en general. ¿Cómo podemos interpretar, en este marco, la formación impositiva, contable o jurídica?